【参考文章】:hadoop集群搭建(hdfs)

1. Hadoop下载

官网下载地址:

https://hadoop.apache.org/releases.html,进入官网根据自己需要下载具体的安装包

清华大学安装包的镜像文件下载地址:

https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-3.1.1/hadoop-3.1.1.tar.gz

解压文件后如图:

2. 修改配置文件

2.1 etc/hadoop/core-site.xml

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://node001:9000</value> <description>NameNode URL</description> </property> <property> <name>hadoop.tmp.dir</name> <value>/home/work/hadoop/temp</value> <description>hadoop的临时本地文件目录</description> </property> <property> <name>io.file.buffer.size</name> <value>131702</value> <description>读写序列文件缓存大小</description> </property> </configuration>

2.2 etc/hadoop/hdfs-site.xml

<configuration> <property> <name>dfs.namenode.name.dir</name> <value>/home/work/hadoop/name</value> <description>本地文件系统存储着命令空间和操作日志 </description> </property> <property> <name>dfs.datanode.data.dir</name> <value>/home/work/hadoop/data</value> <description>存储blocks的本地路径列表,用逗号隔开 </description> </property> <property> <name>dfs.replication</name> <value>1</value> <description> 备份数,根据集群节点合理规划</description> </property> <property> <name>dfs.namenode.secondary.http-address</name> <value>http://localhost:9001</value> <description> namenode 界面访问地址</description> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> <description> 是否使用界面访问</description> </property> </configuration>

2.3 etc/hadoop/hadoop-env.sh

配置 JDK 环境变量,hadoop 不会读取系统的环境变量,需要在hadoop的运行环境配置文件进行配置;

export JAVA_HOME=/home/work/jdk/jdk1.8.0_191

3. 初始化namenode节点

./bin/hadoop namenode -format

4. 启动HDFS

./sbin/start-dfs.sh

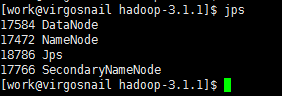

5. 检查运行情况

jps