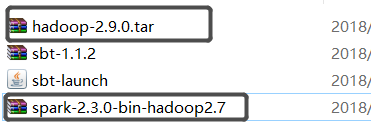

1、下载版本对应的spark和hadoop,如下:

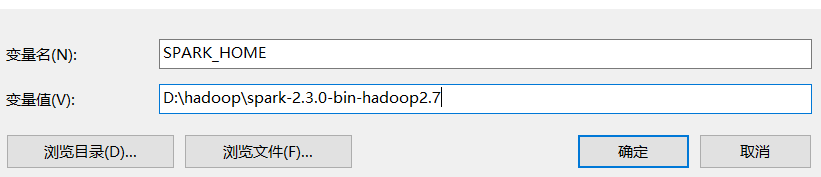

2、配置Spark

解压Spark并配置环境变量,

新建环境变量如下:

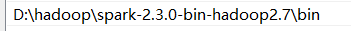

在Path中增加如下环境变量:

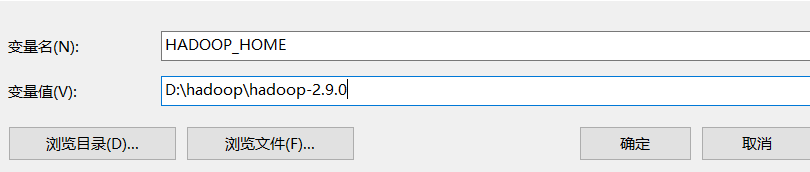

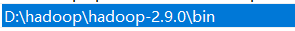

3、配置hadoop相关变量,

4、下载hadoop组件,并进行配置(winutils )

下载地址:https://github.com/srccodes/hadoop-common-2.2.0-bin

将下载好的组件解压放到hadoop_home的bin目录下,不进行文件替换

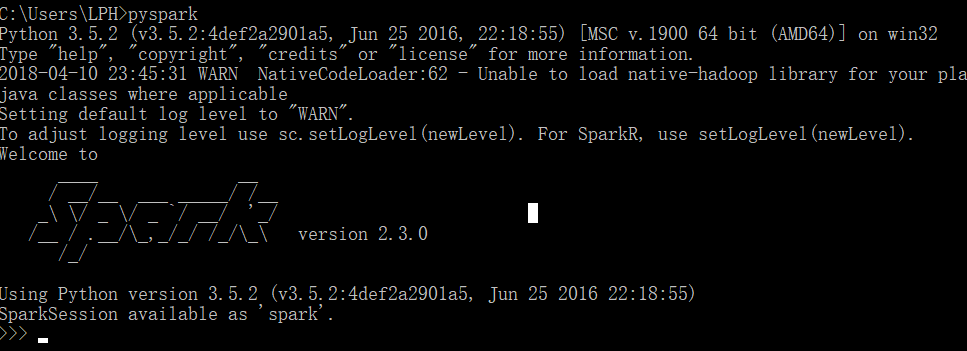

5、验证是否安装成功,打开cmd执行pyspark,成功如下:

6、配置pycharm,安装pycharm,此处不再详细描述

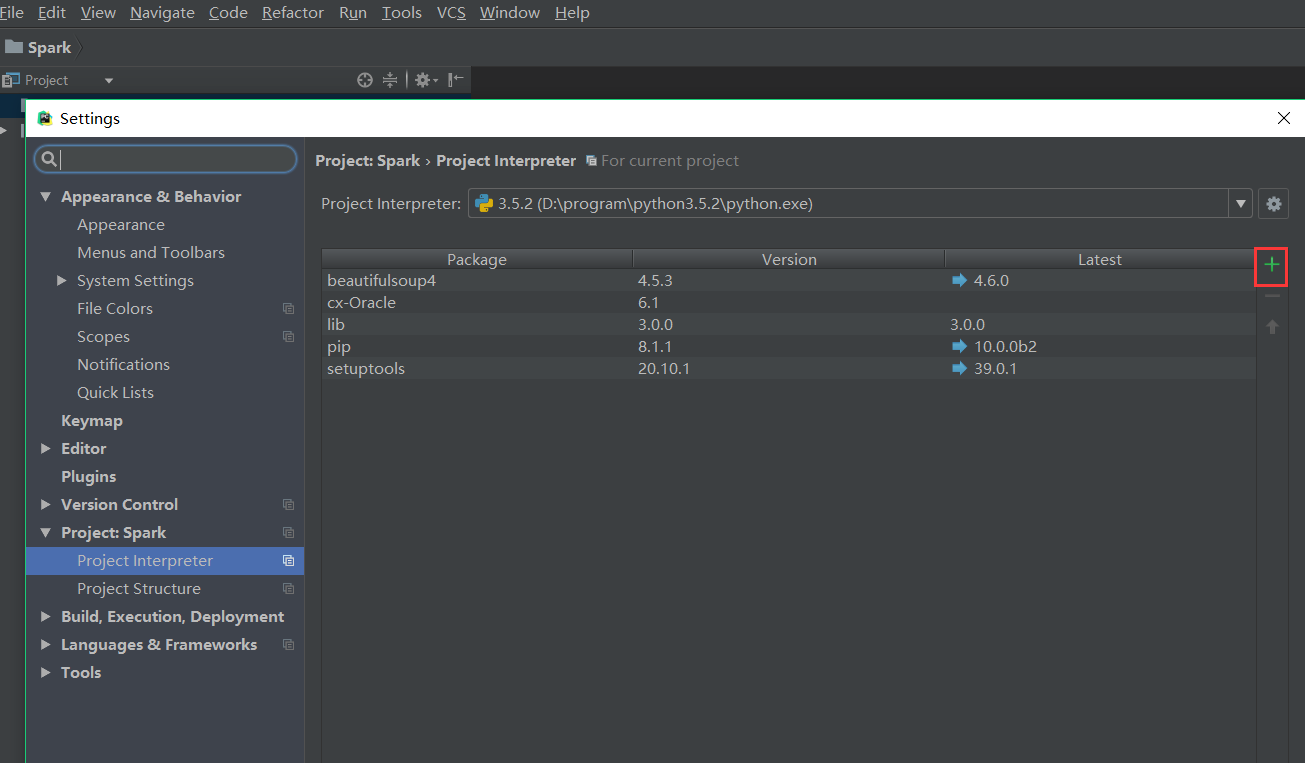

7、为pycharm安装 pyspark组件,file—>settings—>Project Interpreter

安装组件pyspark

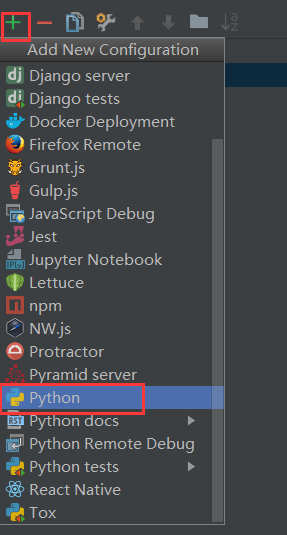

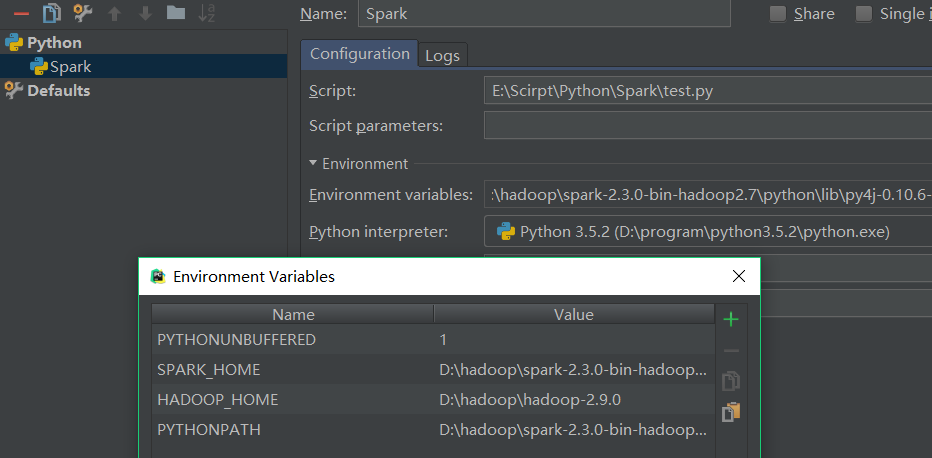

8、配置,环境,run—>Edit Configurations add Python,如下

然后配置如下:

SPARK_HOME : D:hadoopspark-2.3.0-bin-hadoop2.7

HADOOP_HOME : D:hadoophadoop-2.9.0

PYTHONPATH : D:hadoopspark-2.3.0-bin-hadoop2.7pythonlibpy4j-0.10.6-src.zip

9、然后就ok了