作者:张欣

链接:https://www.zhihu.com/question/23765351/answer/98897364

来源:知乎

著作权归作者所有,转载请联系作者获得授权。

链接:https://www.zhihu.com/question/23765351/answer/98897364

来源:知乎

著作权归作者所有,转载请联系作者获得授权。

softmax 回归(Softmax Regression) 这里解释的很详细,简单总结下:

softmax模型是logistic模型在多分类问题上的推广, logistic 回归是针对二分类问题的,类标记为{0, 1}。

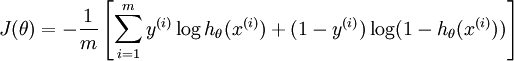

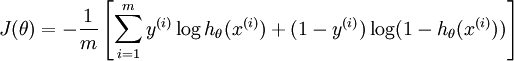

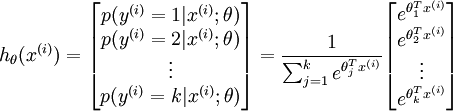

假设函数为: 。

。

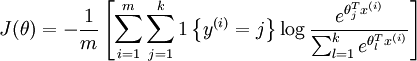

代价函数为:

在softmax模型中,label可以为k个不同的值 。

。

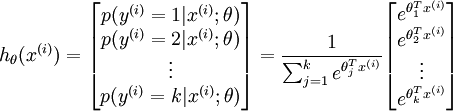

对于给定的测试输入 ,我们想用假设函数针对每一个类别j估算出概率值

,我们想用假设函数针对每一个类别j估算出概率值 。

。

假设函数将输出一个k维的向量

请注意 这一项对概率分布进行归一化,使得所有概率之和为 1 。

这一项对概率分布进行归一化,使得所有概率之和为 1 。

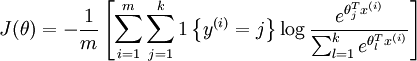

代价函数为: 其中:1{值为真的表达式}=1 为示性函数。

其中:1{值为真的表达式}=1 为示性函数。

如果类别之间是互斥的,适合用softmax;如果类别之间允许重叠,应该选择k个logistic分类器。

softmax模型是logistic模型在多分类问题上的推广, logistic 回归是针对二分类问题的,类标记为{0, 1}。

假设函数为:

代价函数为:

在softmax模型中,label可以为k个不同的值

对于给定的测试输入

假设函数将输出一个k维的向量

请注意

代价函数为:

其中:1{值为真的表达式}=1 为示性函数。

其中:1{值为真的表达式}=1 为示性函数。如果类别之间是互斥的,适合用softmax;如果类别之间允许重叠,应该选择k个logistic分类器。