Lustre文件系统ost损坏,恢复操作

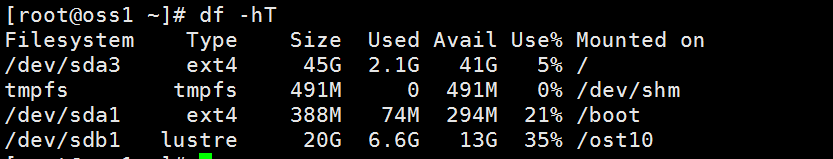

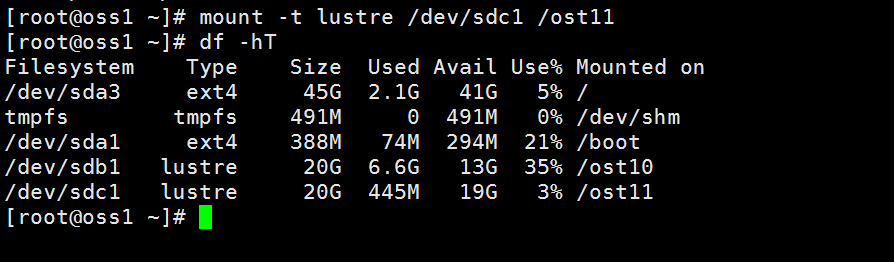

- 已oss1节点为例,一个oss节点挂载了两个OST

2 .假如ost11 损坏,已无法备份OST上的数据。

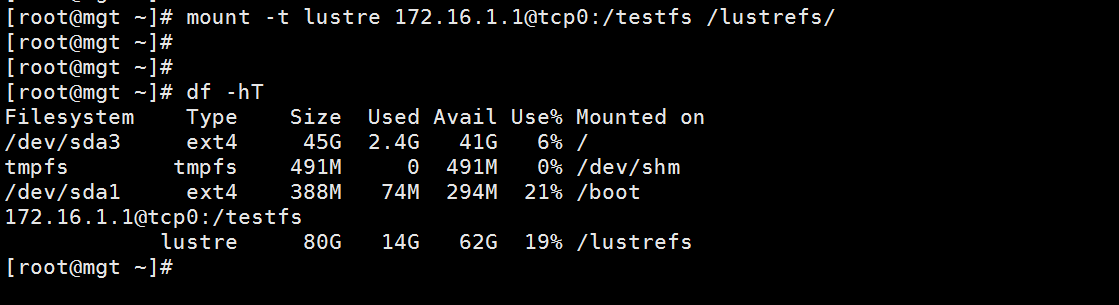

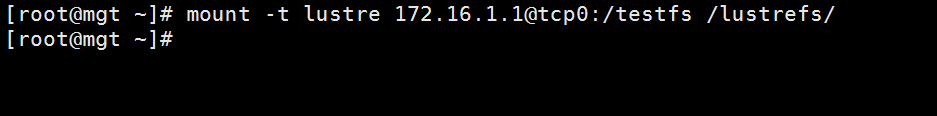

1)尝试在管理节点或登录节点挂载文件系统

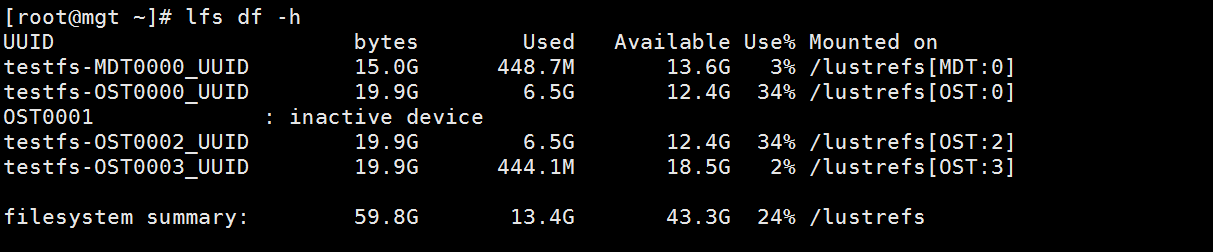

2)执行lfs df -h查看下。

此时OST0001 状态为 inactive device ,OST0001即为损坏的ost11的ID,记录这个ID号后在管理节点上卸载文件系统,umount -l /lustrefs

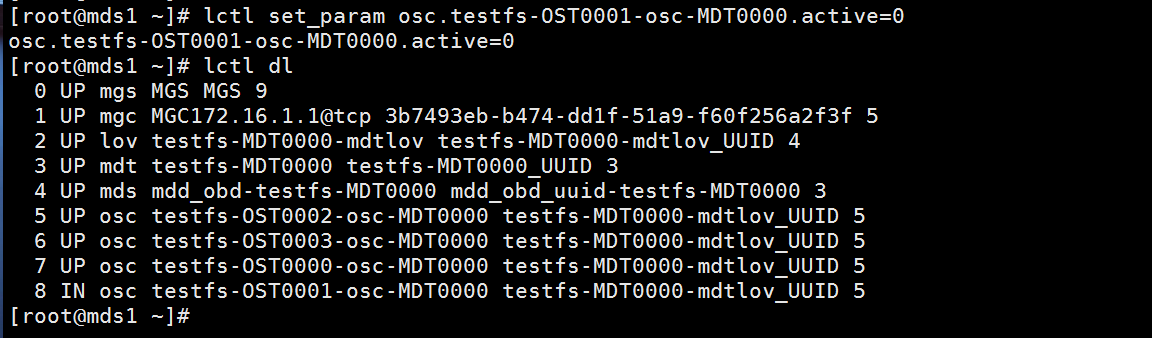

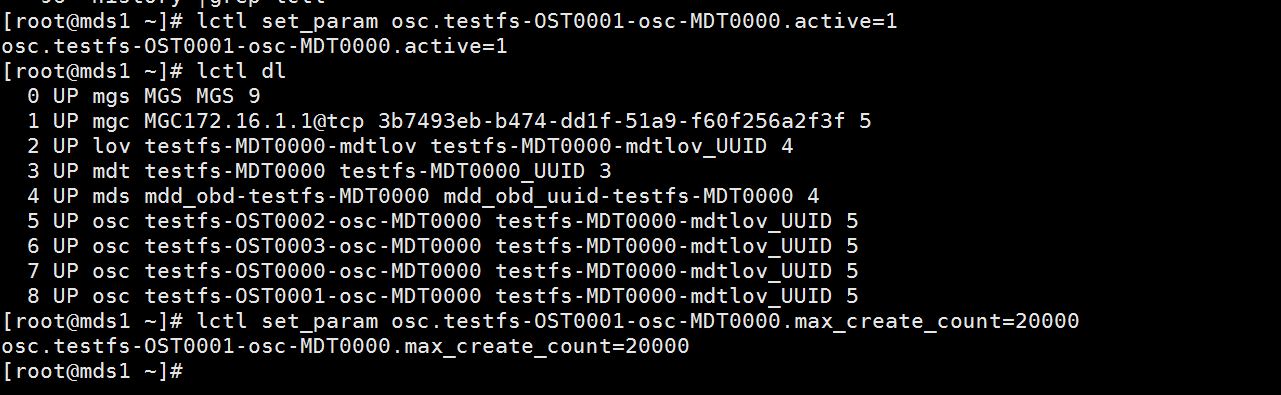

3) 在mds节点上执行lctl dl查看元数据信息。

标红部分为损坏的OST

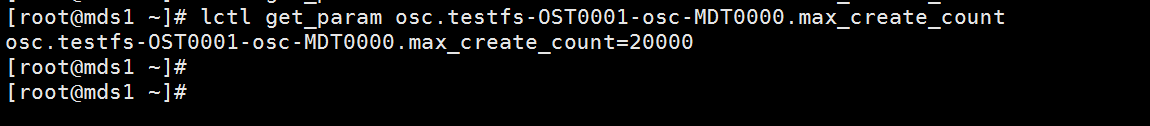

4)查看下OST0001的配置信息

lctl get_param osc.testfs-OST0001-osc-MDT0000.max_create_count

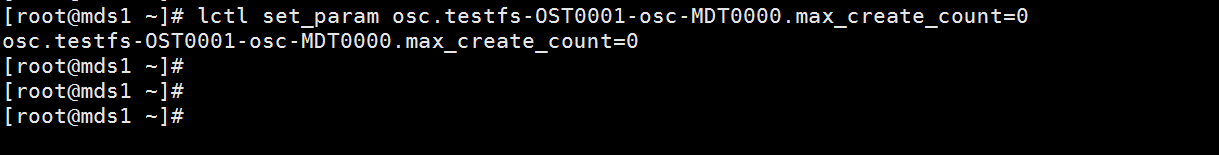

5)把active 和max_create_count的值都设置为0

此时OST0001状态由UP变为IN

备注:active 设置为0还可以使用lctl conf_param testfs-OST0001-osc-MDT0000.active=0或

echo 0 >/proc/fs/lustre/osc/testfs-OST0001-osc-MDT0000/active

6)将ost11对应的/dev/sdc盘格式化,如果是现场环境一定要和用户确认。

使用fdisk 或parted对磁盘进行格式化,fdisk 最多可分配2T的空间。

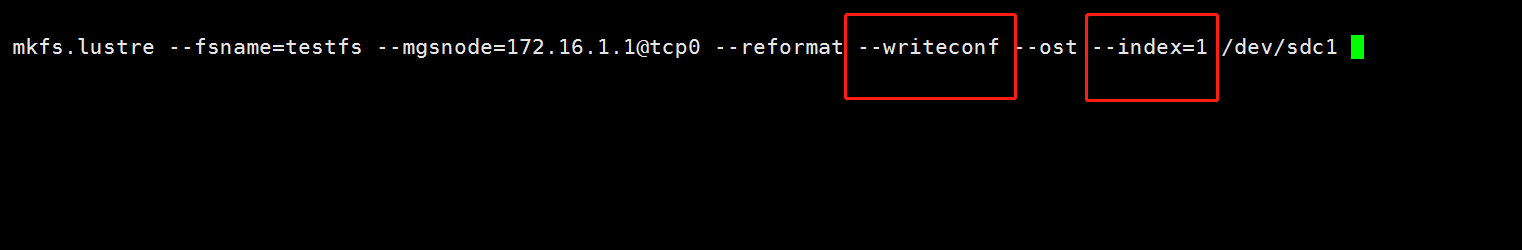

7) 再将磁盘格式化为lustre格式

备注: --writeconf 必要参数,如果lustre版本是最新版的可以将--writeconf 替换为--replace

--index 为OST的ID号。

8) 再次挂载ost

3. 在mds节点上将active和max_create_count 恢复到原来的值

4. 在管理节点或登录节点上重新挂载文件系统即可。