一、数据结构

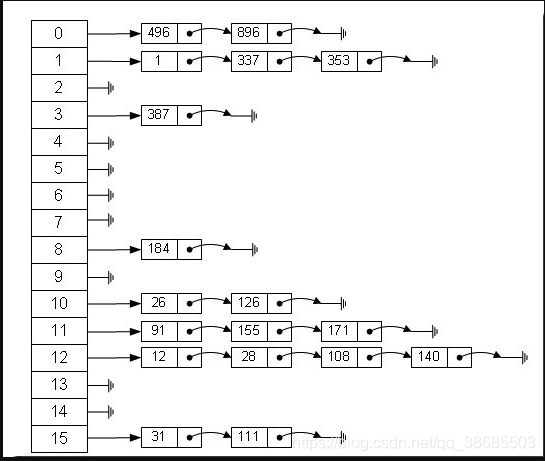

HashMap采用链地址法解决哈希冲突,因此其结构就是由数组+链表组成,数组是HashMap的主体,链表则主要是为了解决哈希冲突而存在的,如果对应的数组位置不含链表,那么查找的时间复杂度仅为O(1),同时不管有无链表,插入操作的时间复杂度也一直为O(1),因为最新的Entry会插入链表头部。当实例化一个HashMap时,系统会创建一个长度为Capacity的Entry数组,这个长度被称为容量(Capacity),在这个数组中可以存放元素的位置我们称之为“桶”(bucket),每个bucket都有自己的索引,系统可以根据索引快速的查找bucket中的元素。每个桶中就可以有一个Entry对象,然后这个Entry对象可以用next指向下一个Entry,最终形成一个Entry链。Entry是HashMap的基本组成单元,每一个Entry都包含一个key-value键值对、指向下一个Entry对象的引用next以及对key的hashcode进行hash运算后得到的hash值,hash值就是为了找到该key应该存储的数组位置。如图:

二、源码解读

1.重要属性

//默认初始化容量是1向左移4位,即16,但并未直接写16,因为操作系统最终会使用二进制进行计算,这样写省略了转换过程,提高了效率。 static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; //最大容量是2的30次方,是30次方的主要原因是int类型是32位整型。 //Java的原始类型里没有无符号类型。因此首位是符号位 正数为0,负数为1 //所以剩下的31位就是正数占30位,负数占30位。 static final int MAXIMUM_CAPACITY = 1 << 30; //threshold的最大值 static final int ALTERNATIVE_HASHING_THRESHOLD_DEFAULT = Integer.MAX_VALUE; //默认负载因子,是0.75的原因主要是“哈希冲突”和“空间利用率”矛盾的一个折中 //加载因子越大,填满的元素越多,空间利用率越高,但冲突的机会加大了。 //从源码中的注释可以知道hash桶中元素个数遵循泊松分布,在负载因子为0.75的时候 //桶中元素个数超过8个几乎是不可能的,所以0.75是解决“哈希冲突”和“空间利用率”矛盾比较优的一个值。 static final float DEFAULT_LOAD_FACTOR = 0.75f; //table数组用于存储Entry对象 transient Entry<K,V>[] table = (Entry<K,V>[]) EMPTY_TABLE; //已使用的数组位置的个数,用于判断是否需要扩容 transient int size; //阈值,当table == {}时,该值为初始容量(初始容量默认为16);当table被填充了 //也就是为table分配内存空间后,threshold一般为 capacity*loadFactory。 //HashMap在进行扩容时需要参考threshold int threshold; //负载因子,表示table的填充度,默认是0.75 final float loadFactor; //由于HashMap不是线程安全的,所以在迭代的时候,会将modCount赋值到迭代器的expectedModCount属性中 //如果在迭代的过程中HashMap被其他线程修改了,modCount的数值就会发生变化, //这时候expectedModCount和ModCount不相等,迭代器就会抛出ConcurrentModificationException()异常 transient int modCount; //对哈希值的散列优化产生影响 transient int hashSeed = 0;

2.构造方法

//通过初始容量和状态因子构造HashMap,其他三个构造方法都会调用此方法 public HashMap(int initialCapacity, float loadFactor) { if (initialCapacity < 0)//参数有效性检查 throw new IllegalArgumentException("Illegal initial capacity: " + initialCapacity); if (initialCapacity > MAXIMUM_CAPACITY)//参数有效性检查 initialCapacity = MAXIMUM_CAPACITY; if (loadFactor <= 0 || Float.isNaN(loadFactor))//参数有效性检查 throw new IllegalArgumentException("Illegal load factor: " + loadFactor); this.loadFactor = loadFactor; threshold = initialCapacity; init();//init方法在HashMap中没有实际实现,不过在其子类如 linkedHashMap中就会有对应实现 } //通过扩容因子构造HashMap,容量为默认值,即16 public HashMap(int initialCapacity) { this(initialCapacity, DEFAULT_LOAD_FACTOR); } //装载因子取0.75,容量取16,构造HashMap public HashMap() { this(DEFAULT_INITIAL_CAPACITY, DEFAULT_LOAD_FACTOR); } //通过其他Map来初始化HashMap,容量通过传入map的size来计算,装载因子取0.75 public HashMap(Map<? extends K, ? extends V> m) { this(Math.max((int) (m.size() / DEFAULT_LOAD_FACTOR) + 1, DEFAULT_INITIAL_CAPACITY), DEFAULT_LOAD_FACTOR); inflateTable(threshold);//初始化HashMap底层的数组结构 putAllForCreate(m);//添加m中的元素 }

3.get()

// 获取key对应的value public V get(Object key) { if (key == null) //如果key为null,调用getForNullKey() return getForNullKey(); //key不为null,调用getEntry(key); Entry<K,V> entry = getEntry(key); return null == entry ? null : entry.getValue(); } //当key为null时,获取value private V getForNullKey() { if (size == 0) { return null;//链表为空,返回null } //链表不为空,将“key为null”的元素存储在table[0]位置,但不一定是该链表的第一个位置! for (Entry<K,V> e = table[0]; e != null; e = e.next) { if (e.key == null) return e.value; } return null; } //key不为null,获取value final Entry<K,V> getEntry(Object key) { if (size == 0) {//判断链表中是否有值 //链表中没值,也就是没有value return null; } //链表中有值,获取key的hash值 int hash = (key == null) ? 0 : hash(key); // 在“该hash值对应的链表”上查找“键值等于key”的元素 for (Entry<K,V> e = table[indexFor(hash, table.length)]; e != null; e = e.next) { Object k; //判断key是否相同 if (e.hash == hash && ((k = e.key) == key || (key != null && key.equals(k)))) return e;//key相等,返回相应的value } return null;//链表中没有相应的key }

4.put()/putForNullKey()

// 将“key-value”添加到HashMap中 public V put(K key, V value) { if (table == EMPTY_TABLE) { inflateTable(threshold); } if (key == null)// 若“key为null”,则将该键值对添加到table[0]中。 return putForNullKey(value); // 若“key不为null”,则计算该key的哈希值,然后将其添加到该哈希值对应的链表中。 int hash = hash(key);//获取key的hash值 int i = indexFor(hash, table.length); for (Entry<K,V> e = table[i]; e != null; e = e.next) { Object k; if (e.hash == hash && ((k = e.key) == key || key.equals(k))) { // 若“该key”对应的键值对已经存在,则用新的value取代旧的value。然后退出! V oldValue = e.value; e.value = value; e.recordAccess(this); return oldValue; } } // 若“key”对应的键值对不存在,则将“key-value”添加到table中 modCount++; //将key-value添加到table[i]处 addEntry(hash, key, value, i); return null; } //插入键为null的值 private V putForNullKey(V value) { //key为null的值永远被放在哈希表的第一个桶中 for (Entry<K,V> e = table[0]; e != null; e = e.next) { //一旦找到键为null,替换旧值 if (e.key == null) { V oldValue = e.value; e.value = value; e.recordAccess(this); return oldValue; } } //如果第一个桶还是空则插入新节点 modCount++; addEntry(0, null, value, 0); return null; }

5.addEntry()/createEntry()

void addEntry(int hash, K key, V value, int bucketIndex) { //先判断大小 if ((size >= threshold) && (null != table[bucketIndex])) { //若HashMap的实际大小不小于 “阈值”,则进行扩容 resize(2 * table.length);//每次扩容2倍 hash = (null != key) ? hash(key) : 0; bucketIndex = indexFor(hash, table.length); } //新增Entry,将“key-value”插入指定位置,bucketIndex是位置索引 createEntry(hash, key, value, bucketIndex); } void createEntry(int hash, K key, V value, int bucketIndex) { // 保存“bucketIndex”位置的值到“e”中 Entry<K,V> e = table[bucketIndex]; // 设置“bucketIndex”位置的元素为“新Entry”, // 设置“e”为“新Entry的下一个节点” table[bucketIndex] = new Entry<>(hash, key, value, e); //已使用数组位置+1 size++; } //进行头插,创建一个新的entry Entry(int h, K k, V v, Entry<K,V> n) { value = v; next = n; key = k; hash = h; }

6.resize()

// 重新调整HashMap的大小,newCapacity是调整后的新容量 void resize(int newCapacity) { Entry[] oldTable = table; int oldCapacity = oldTable.length; if (oldCapacity == MAXIMUM_CAPACITY) { //当旧容量已达上限,阈值则也取上限,因为不可能再扩容了 //所以此时也管不了性能问题了,能扩多大扩多大 threshold = Integer.MAX_VALUE; return; } //新建一个HashMap,将“旧HashMap”的全部元素添加到“新HashMap”中, //然后,将“新HashMap”赋值给“旧HashMap”。 Entry[] newTable = new Entry[newCapacity]; transfer(newTable, initHashSeedAsNeeded(newCapacity)); table = newTable; threshold = (int)Math.min(newCapacity * loadFactor, MAXIMUM_CAPACITY + 1); }

7.transfer()

// 将HashMap中的全部元素都添加到newTable中 void transfer(Entry[] newTable, boolean rehash) { int newCapacity = newTable.length; for (Entry<K,V> e : table) { while(null != e) { Entry<K,V> next = e.next; //重新计算元素在新数组中的索引位置 if (rehash) { e.hash = null == e.key ? 0 : hash(e.key); } int i = indexFor(e.hash, newCapacity); //扩容后的新数组的桶中链表元素顺序颠倒 e.next = newTable[i]; newTable[i] = e; e = next; } } }

8.inflateTable()

//初始化底层数组 private void inflateTable(int toSize) { // Find a power of 2 >= toSize int capacity = roundUpToPowerOf2(toSize); //获取阈值 threshold = (int) Math.min(capacity * loadFactor, MAXIMUM_CAPACITY + 1); table = new Entry[capacity]; initHashSeedAsNeeded(capacity);//初始化hashSeed变量 } //获取不小于初始容量的最小的2的指数倍数的数作为数组的大小 private static int roundUpToPowerOf2(int number) { return number >= MAXIMUM_CAPACITY ? MAXIMUM_CAPACITY : (number > 1) ? Integer.highestOneBit((number - 1) << 1) : 1; }

9.hash()/indexFor()

//获取key的哈希值 final int hash(Object k) { //通过更新hashSeed来修改hash值达到分散的目的 int h = hashSeed;//默认为0 if (0 != h && k instanceof String) { return sun.misc.Hashing.stringHash32((String) k); } //异或运算保证不会影响返回的hashCode值(异1同0) h ^= k.hashCode(); h ^= (h >>> 20) ^ (h >>> 12); return h ^ (h >>> 7) ^ (h >>> 4); } //通过hash值和数组长度返回数组下标 //length-1是因为数组长度都是2的n次幂,只要再减去1,转换成二进制最高位肯定为0,其他位全为1 //此时进行位与运算就不会对hashcode值产生任何影响,会完整的得到原hashcode值的低位值,也有效降低了发生哈希冲突的概率 static int indexFor(int h, int length) { return h & (length-1); }

10.remove()

public V remove(Object key) { Entry<K,V> e = removeEntryForKey(key); return (e == null ? null : e.value); } final Entry<K,V> removeEntryForKey(Object key) { if (size == 0) { return null; } //计算hash值 int hash = (key == null) ? 0 : hash(key); //得到桶索引 int i = indexFor(hash, table.length); //记录待删除节点的前一个节点 Entry<K,V> prev = table[i]; //待删除节点 Entry<K,V> e = prev; //遍历 while (e != null) { Entry<K,V> next = e.next; Object k; //如果匹配,则删除节点 if (e.hash == hash && ((k = e.key) == key || (key != null && key.equals(k)))) { modCount++; size--; if (prev == e) table[i] = next; else prev.next = next; e.recordRemoval(this); return e; } prev = e; e = next; } return e; }

put 当key相同返回之前相同key的值

当key与之前的key不同返回null

Integer.highestOneBit(int i) 找到的是一个<= 2次方数

异或:相同取0,相异取1

同或:相同取1,相异取0

扩容的目的:增加存储空间 、减短链表长度,提高get的效率

hashmap中 index 需要满足的两个条件

1、index>=0 且 index<length

2、产生的index的值是平均的

HashMap的put方法总结

- PUT(key,value)

- int hashcode = key.hashCode();

- int index = hashcode & (数组长度-1)

- 遍历index位置的链表,如果存在相同的key,则进行value覆盖,并且返回之前的value值

- 将key,value封装为节点对象(Entry)

- 将节点插在index位置上的链表的头部

- 将链表头节点移动到数组上

这是最核心的7步,然后在这个过程中还有很重要的一步就是扩容,而扩容是

参考:https://blog.csdn.net/qq_38685503/article/details/88387825