今天安装配置了spark,主要是按照林子雨老师的教程安装的。其中在下载sbt和用sbt将程序进行打包时花费了大量的时间(可能是因为网络不佳吧)。

一.安装

1.从spark官网选择版本进行下载。若已装有hadoop则第二项选择如图所示。

2.解压安装后,还需要修改Spark的配置文件spark-env.sh

cd /usr/local/spark

cp ./conf/spark-env.sh.template ./conf/spark-env.sh

编辑spark-env.sh文件(vim ./conf/spark-env.sh),在第一行添加以下配置信息:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

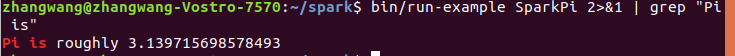

3.通过运行Spark自带的示例,验证Spark是否安装成功。

cd /usr/local/spark

bin/run-example SparkPi

执行时会输出非常多的运行信息,输出结果不容易找到,可以通过 grep 命令进行过滤(命令中的 2>&1 可以将所有的信息都输出到 stdout 中,否则由于输出日志的性质,还是会输出到屏幕中):

bin/run-example SparkPi 2>&1 | grep "Pi is"

验证结果:

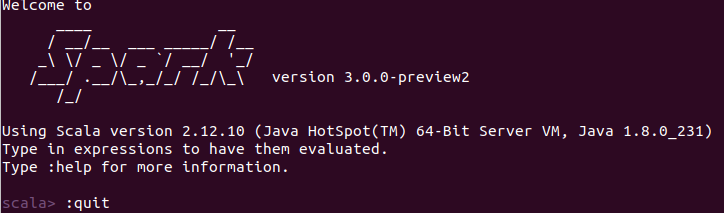

二.在spark shell中运行代码

使用命令进入spark-shell环境,可以通过下面命令启动spark-shell环境

cd /usr/local/spark

bin/spark-shell

启动spark-shell后,就会进入“scala>”命令提示符状态,如下图所示

可以使用命令“:quit”退出Spark Shell,或者,也可以直接使用“Ctrl+D”组合键,退出Spark Shell。