安装JDK1.8

查看JDK1.8的安装

https://www.cnblogs.com/TJ21/p/13208514.html

安装hadoop

上传hadoop

下载hadoop 地址http://mirrors.hust.edu.cn/apache/hadoop/common/

放到mkdir /usr/local/src/hadoop目录下

解压 tar -zxvf hadoop-2.9.2.tar.gz

配置环境变量

vi /etc/profile 添加如下配置 export HADOOP_HOME=/usr/local/src/hadoop/hadoop-2.9.2 export PATH=$HADOOP_HOME/bin:$PATH 重新刷新配置 source /etc/profile 查看版本 hadoop version

修改配置文件

vi core-site.xml

路径是 cd /usr/local/src/hadoop/hadoop-2.9.2/etc/hadoop

vi core-site.xml 添加如下配置

<property>

<name>fs.defaultFS</name>

<!-- 这里填的是你自己的ip,端口默认-->

<value>hdfs://192.168.0.130:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<!-- 这里填的是你自定义的hadoop工作的目录,端口默认-->

<value>/usr/local/src/hadoop/hadoop-2.9.2/tmp</value>

</property>

<property>

<name>hadoop.native.lib</name>

<value>false</value>

<description>Should native hadoop libraries, if present, be used.

</description>

</property>

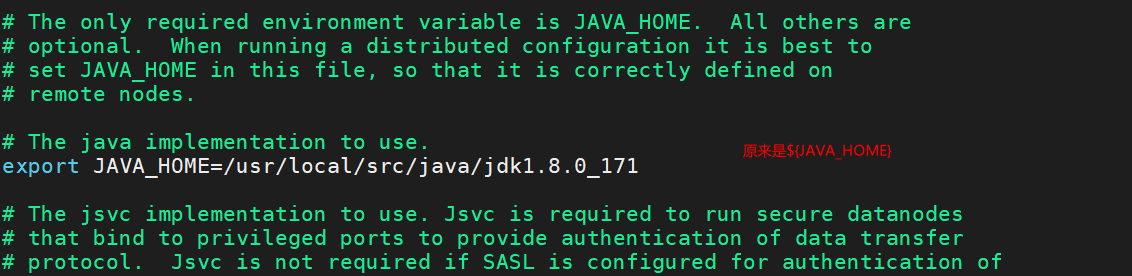

vi hadoop-env.sh 配置成你自己的jdk安装路径

vi hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.secondary.http.address</name>

<!--这里是你自己的ip,端口默认-->

<value>192.168.0.130:50090</value>

</property>

vi mapred-site.xml

复制默认的cp mapred-site.xml.template ./mapred-site.xml 配置命名为mapred-site.xml

vi mapred-site.xml 添加如下配置

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

配置yarn-site.xml

<property>

<name>yarn.resourcemanager.hostname</name>

<!-- 自己的ip端口默认 -->

<value>192.168.0.130</value>

</property>

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

配置完成启动

配置好之后切换到sbin目录下

cd /usr/local/src/hadoop/hadoop-2.9.2/sbin/ 查看命令 ll

格式化hadoop文件格式,执行命令 hadoop namenode -format,成功之后启动

执行启动所有命令

./start-all.sh

没启动一个进程需要输入密码,可以通过配置ssh来解决,就不需要输入了,暂时配置

使用 jps 查看进程,能看到这些进程证明启动成功了,

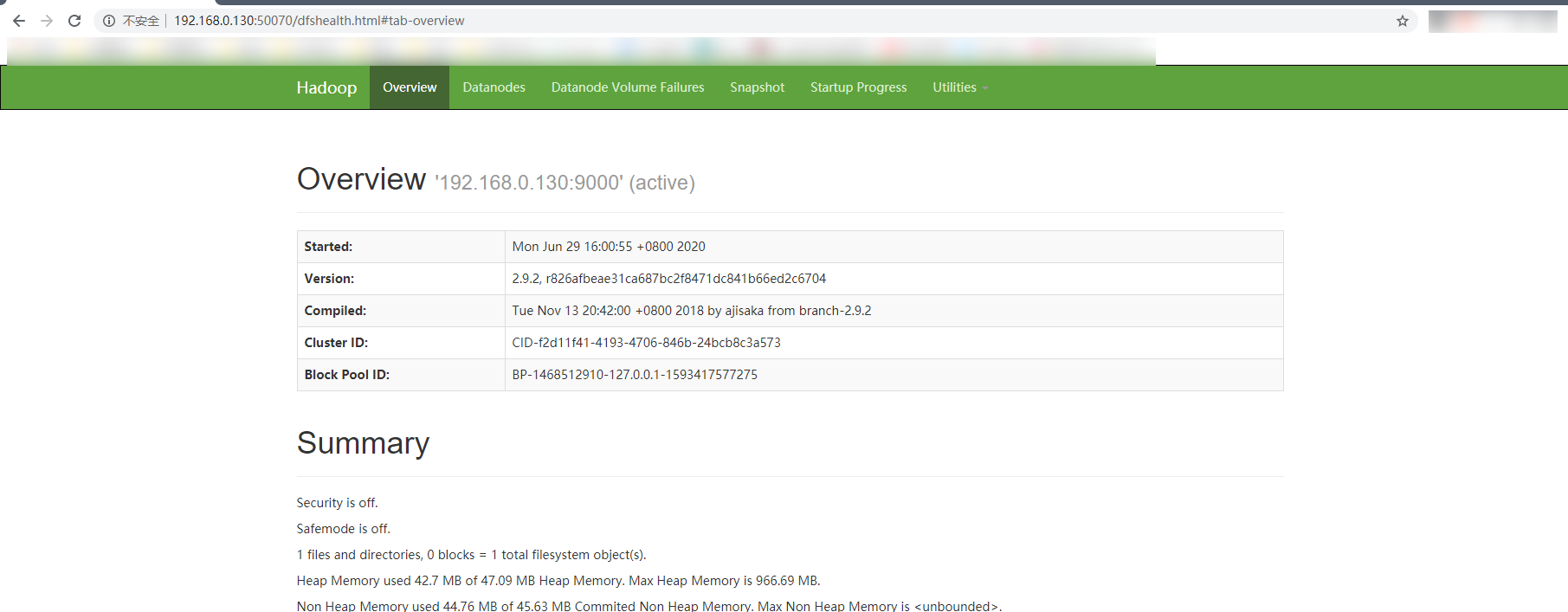

也可以通过网页来查看 192.168.0.130:50070 此处的ip是自己的虚拟机IP

关闭防火墙的方法为:

systemctl stop firewalld.service #停止firewall systemctl disable firewalld.service #禁止firewall开机启动