python环境 导入pyspark.sql

1.linux系统下,spark读取hive表

配置文件: 先将hive-site.xml放入linux spark内的conf内 //hive和linux下的spark连接 将jar包 mysql-connector-java.jar放入linux spark内的jars

如图:

2.在windows系统内,配置spark

配置文件: 将linux内的spark/conf文件替换掉windows下的conf文件,hive-site.xml内的ip根据自己实际情况改动 将mysql-connector-java.jar拷入windows 下spark/jars内

3.PyChrome下测试

方式一:配置环境变量 自动读取

spark = SparkSession.builder.master("local[*]")

.appName("test").enableHiveSupport().getOrCreate()

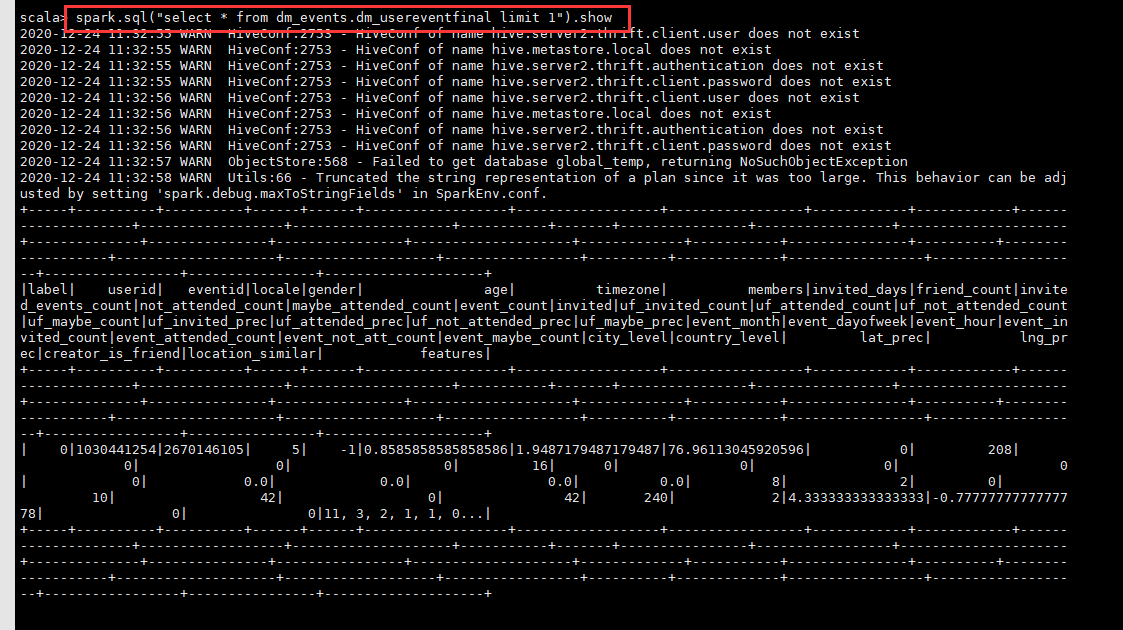

read_df=spark.sql("select * from dm_events.dm_usereventfinal limit 1")

read_df.show()

方式二:不需配置环境变量

spark = SparkSession.builder.master("spark://192.168.142.197:7077")

.config("hive.metastore.uris","thrift://192.168.142.197:9083")

.appName("test").enableHiveSupport().getOrCreate()

read_df = spark.sql("select * from dm_events.dm_usereventfinal limit 1")

read_df.show()

注:也可以尝试直接DOS内尝试

>>pyspark

>>spark.sql("sql_sentence").show()