1,安装hadoop

我下载的安装包 hadoop-3.2.0.tar.gz

解压包到/usr/local目录下,并mv hadoop-3.2.0 hadoop

接着添加环境变量

vi /etc/profile

再最后添加 export PATH=$PATH:/usr/local/hadoop/bin

保存后 source /etc/profile .

检查 是否安装成功:which hadoop。

2,配置hadoop-env.sh

在hadoop-env.sh中添加java 环境变量

export JAVA_HOME=/usr/java/jdk1.8.0_40

3,配置core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/hadoop/hadoop/dfs</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

全局配置

hadoop.tmp.dir: 指定了一块临时目录,供后面创建节点使用

fs.defaultFS: 指定了hdfs 的 NameNode RPC 交互接口

3,配置hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/hadoop/dfs/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/hadoop/dfs/dfs/data</value>

</property>

<property>

<name>dfs.http.address</name>

<value>127.0.0.1:50070</value>

</property>

</configuration>

hdfs配置

dfs.replication:指定了hdfs 中每个block被复制的次数。我们这里的伪分布式只有一个数据节点,所以设置为1.

dfs.namenode.name.dir:指定了hdfs 的NameNode 的目录路径

dfs.datanode.data.dir:指定了hdfs 的DataNode 的目录路径

dfs.http.address:指定了http访问的地址与端口。

3,配置mapred-site.xml

mapreduce配置

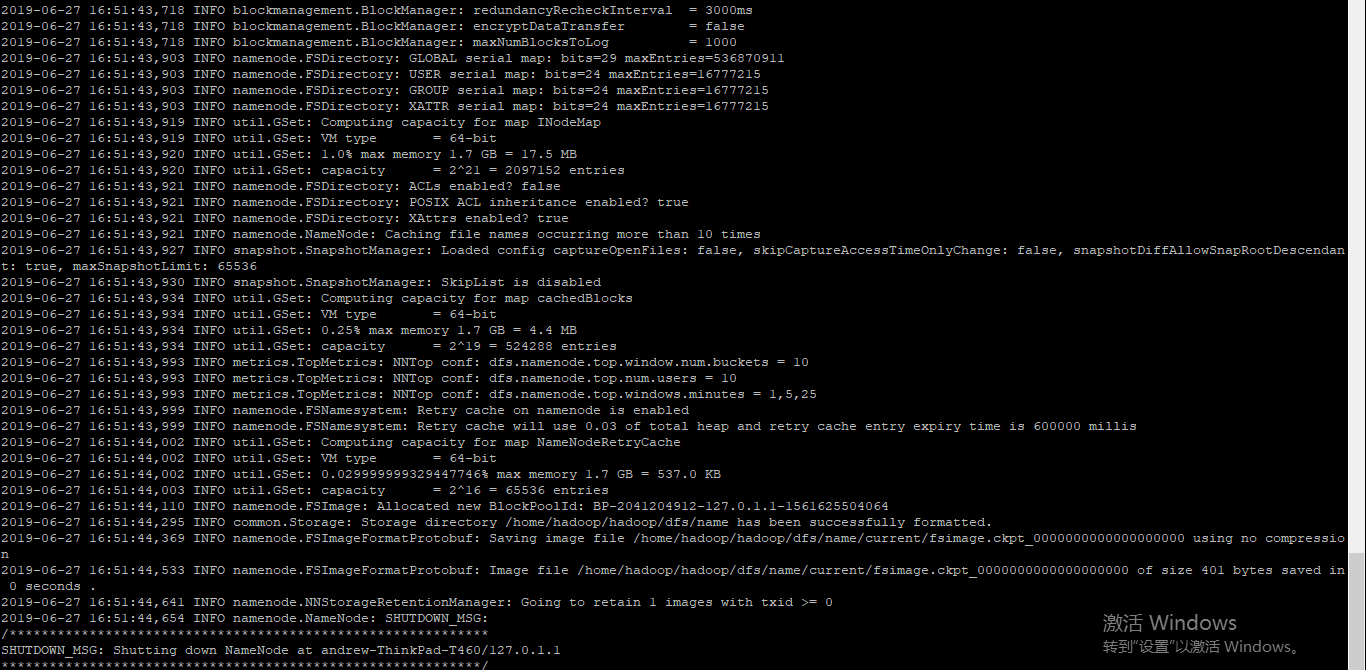

4,格式化hdfs

hadoop namenode –format

执行结果:在/home/hadoop/hadoop/dfs 目录下产生name目录

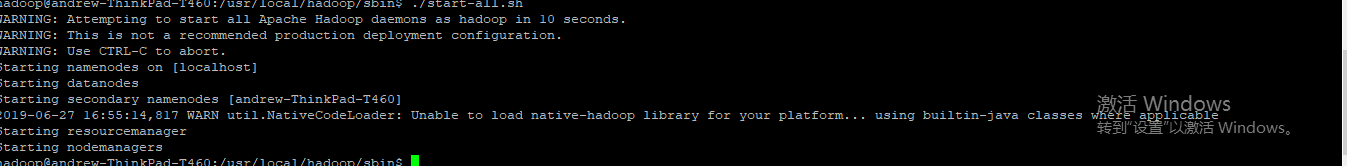

5,启动

./sbin/start-all.sh

执行结果如下

6, 浏览器浏览 127.0.0.1:50070,显示hadoop页面成功