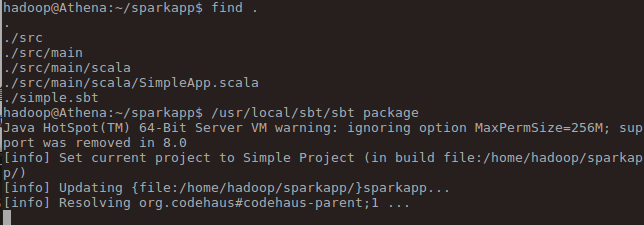

cd sparkapp/lsfind ./usr/local/sbt/sbt package

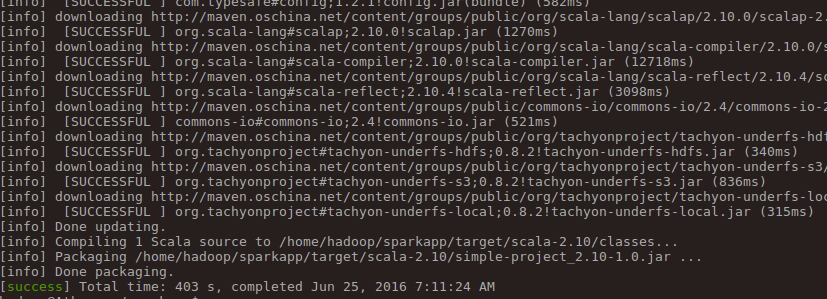

package完成:

hadoop@Athena:~/sparkapp$ lsprojectsimple.sbt srctarget

打包位置:

我们就可以将生成的 jar 包通过 spark-submit 提交到 Spark 中运行:

/usr/local/spark/bin/spark-submit --class "SimpleApp" ~/sparkapp/target/scala-2.10/simple-project_2.10-1.0.jar

/usr/local/spark/bin/spark-submit --class "SimpleApp" ~/sparkapp/target/scala-2.10/simple-project_2.10-1.0.jar 2>&1 | grep "Lines with a:"//精简信息查看运行结果。

- 如果想对 Spark 的 API 有更深入的了解,可查看的 Spark 编程指南(Spark Programming Guide);

- 如果你想对 Spark SQL 的使用有更多的了解,可以查看 Spark SQL、DataFrames 和 Datasets 指南;

- 如果你想对 Spark Streaming 的使用有更多的了解,可以查看 Spark Streaming 编程指南;

- 如果需要在集群环境中运行 Spark 程序,可查看官网的 Spark 集群部署

参考/转载:http://www.powerxing.com/spark-quick-start-guide/