线性回归(Linear Regression)

是利用称为线性回归方程的最小平方函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。这种函数是一个或多个称为回归系数的模型参数的线性组合(自变量都是一次方)。只有一个自变量的情况称为简单回归,大于一个自变量情况的叫做多元回归。

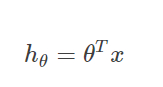

线性回归的模型函数如下:

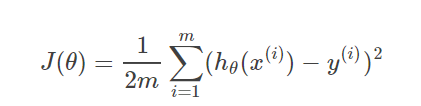

损失函数(基于均方误差最小化)

通过训练数据集寻找参数的最优解,即求解可以得minJ(θ)的参数向量θ,其中这里的参数向量也可以分为参数和w和b,分别表示权重和偏置值。

线性回归方程可通过两种方法求解,一种是梯度下降法(上篇博文已提到),另外一种就是通过正规方程组来求解,下面介绍正规方程组:

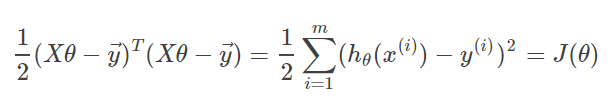

将数据集的数据写成矩阵的形式:

则损失函数可以写成:

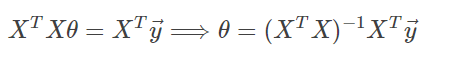

求解正规方程组可得:

在这个方程组中需要求解(XTX)逆,需要(XTX)不满秩。即希望X的列数多于行数。

logistic回归

logistic回归也称为逻辑回归,是一种广义线性模型,它将分类任务的真实标记与线性回归模型的预测值联系起来。

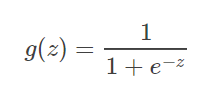

逻辑回归的假设函数为

或者:

这个假设函数叫逻辑函数(Logistic function)或者是S形函数(Sigmoid function),其输出值在z=0处变化很陡。

这个函数有几个优点:

一:它是直接对分类可能性进行建模,无需事先假设数据分布,这样可以避免分布不准确所带来的问题。

二:它不仅预测出类别,而是可以得到近似概率预测,这对许多需要利用概率辅助决策的任务很有用。

三:是任意阶可导的凸函数,有很好的数学性质,求导结果:![]() 。

。

逻辑回归函数求解:通过最大似然估计来求解θ

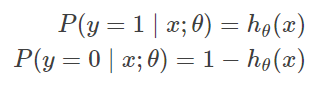

逻辑回归用于二分类的问题,y属于{0,1}的问题,服从一个伯努利分布(Bernoulli distribution):

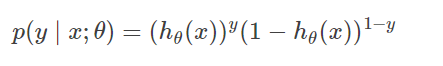

将两式写在一起:

明显当y=1时是第一个式子,当y=0时,是第二个式子。

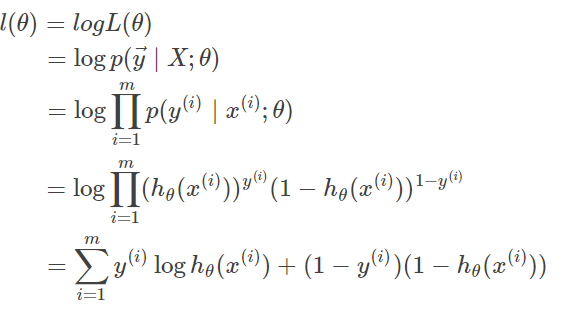

对于概率问题,有m个样本,我们可以得到它的对数似然函数:

这样有了目标函数l(θ),根据极大似然定理 ,当l(θ)最大的时候取得的θ,即为模型的最优解。

而逻辑回归的代价函数就是−l(θ),即−l(θ)越小越好。得到下式:

用梯度下降公式求解:

可得到迭代公式:

总结

线性模型

优点:结果易于理解,计算上不复杂。

缺点:对非线性数据拟合不好。

逻辑回归模型:

优点:实现简单;分类时计算量非常小,速度很快,存储资源低;

缺点:容易欠拟合,一般准确度不太高,只能处理两分类问题(在此基础上衍生出来的softmax可以用于多分类),且必须线性可分;

最后,本文没有对softmax函数进行推导,但是softmax函数在深度学习里面有很多应用,是有必要弄懂的一个函数。