不多说,直接上干货!

参考博客

基于Web的Kafka管理器工具之Kafka-manager的编译部署详细安装 (支持kafka0.8、0.9和0.10以后版本)(图文详解)(默认端口或任意自定义端口)

但是,要注意的是,因为在amabri集群里啊,10000端口默认是给了oozie的。

然而,我上述的博客,是当时手动临时给的10000端口给kafka-manager,所以,对此,我这里改变端口,具体如下。

一、给基于Ubuntu14.04的ambari集群里的kafka安装基于web的kafka管理工具Kafka-manager

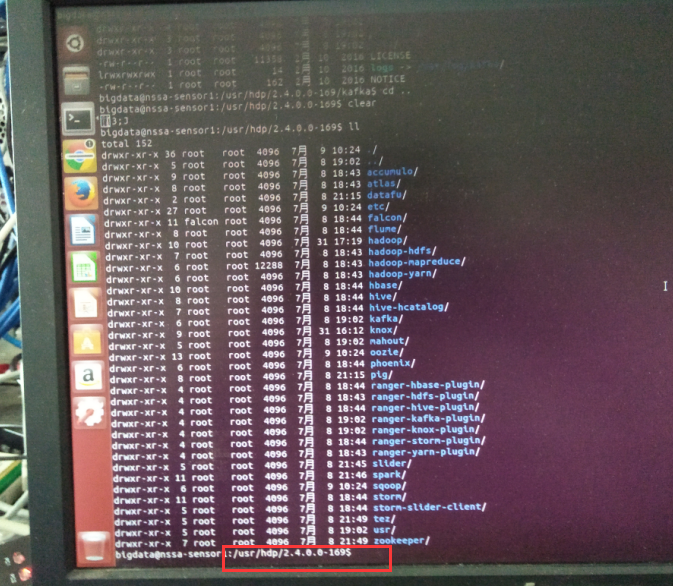

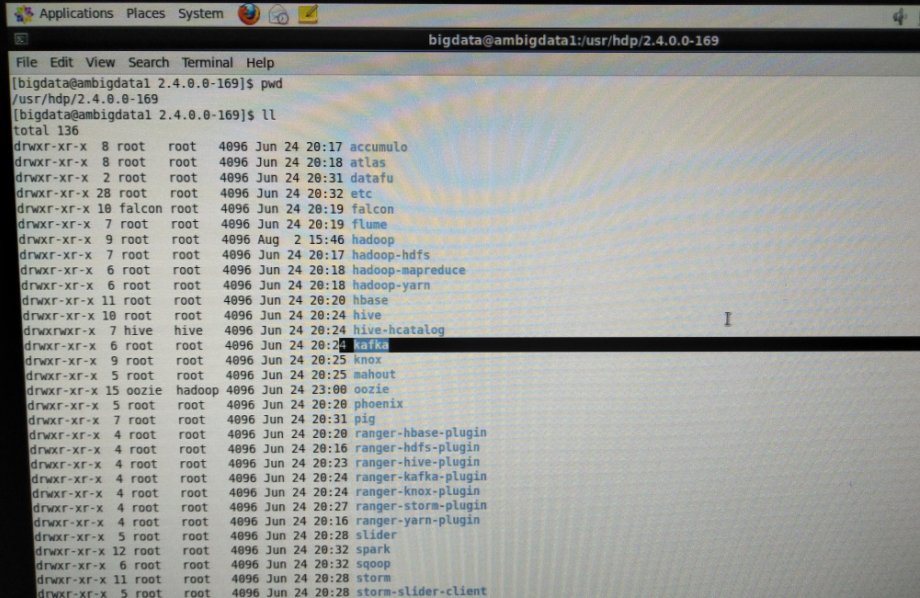

我这里,打算为了目录管理方便起见,安装Kafka-manager在/usr/hdp/2/4.0.0-169目录下。

具体过程见基于centos6.5,我这里就不贴图了,过程是完全一样的。

二、给基于CentOS6.5的ambari集群里的kafka安装基于web的kafka管理工具Kafka-manager

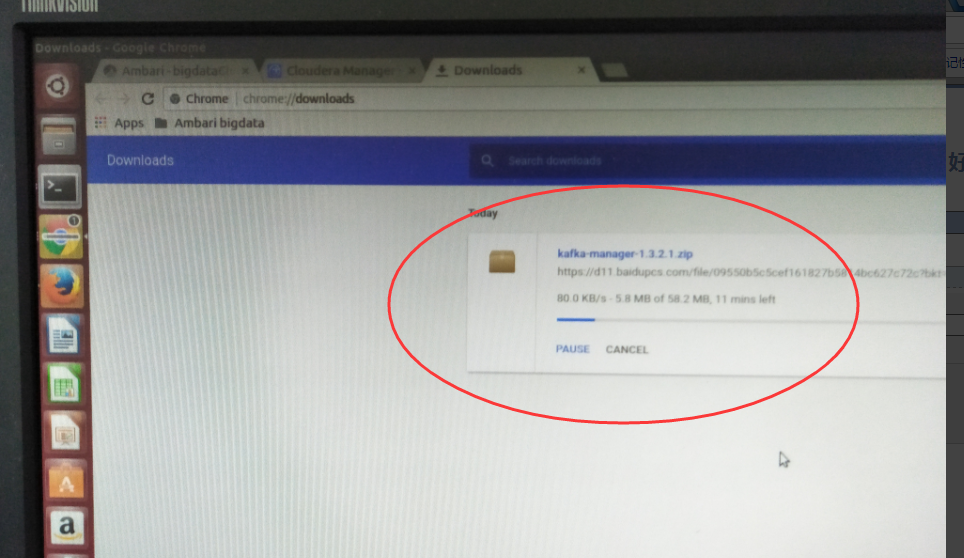

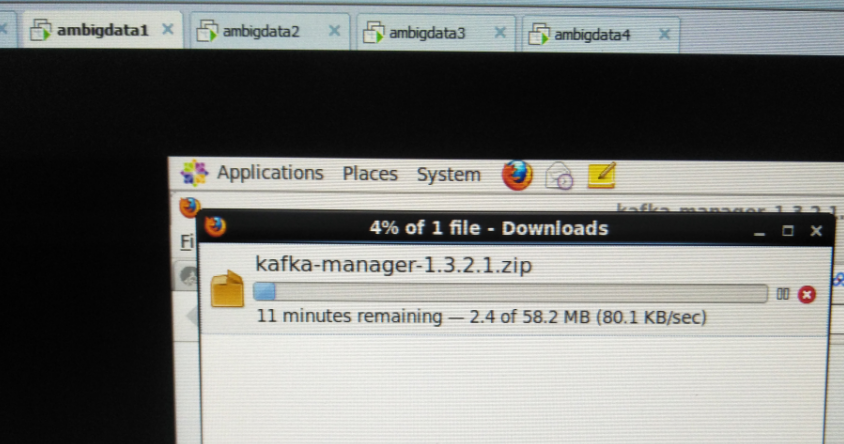

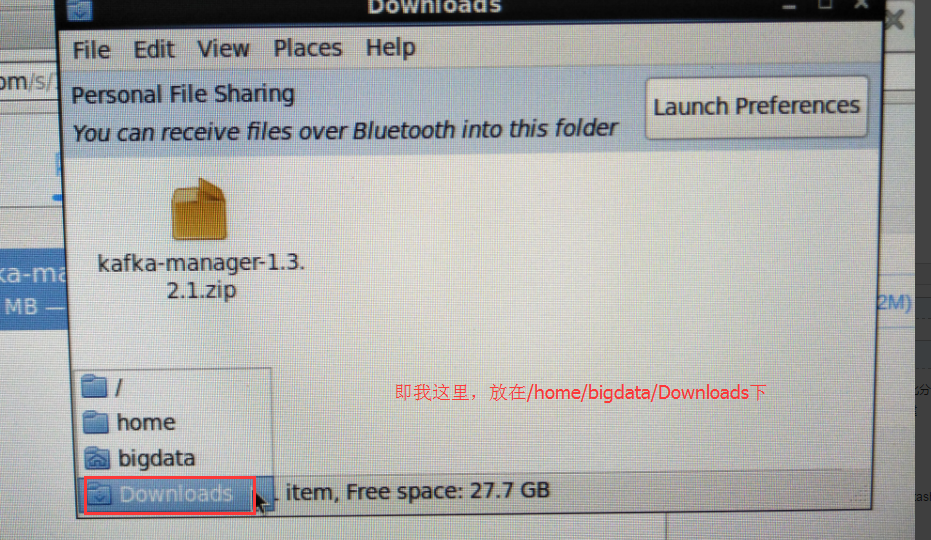

下载

我这里,打算为了目录管理方便起见,安装Kafka-manager在/usr/hdp/2/4.0.0-169目录下。

[hadoop@ambigdata1 2.4.0.0.-169]$ unzip kafka-manager-1.3.2.1.zip

[hadoop@ambigdata1 2.4.0.0-169]$ rm kafka-manager-1.3.2.1.zip [hadoop@ambigdata1 2.4.0.0-169]$ cd kafka-manager-1.3.2.1/

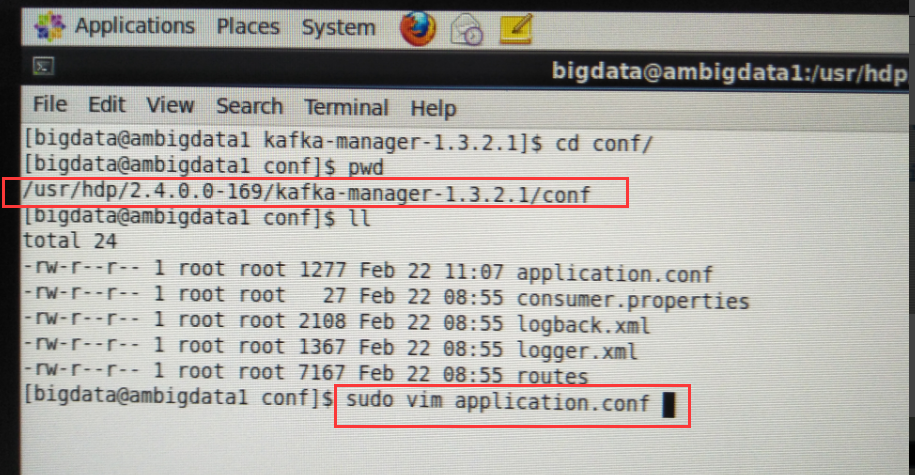

[hadoop@ambigdata1 conf]$ pwd /usr/hdp/2.4.0.0-169/kafka-manager-1.3.2.1/conf [hadoop@ambigdata1 conf]$ ll total 24 -rw-r--r-- 1 hadoop hadoop 1277 Feb 22 11:07 application.conf -rw-r--r-- 1 hadoop hadoop 27 Feb 22 08:55 consumer.properties -rw-r--r-- 1 hadoop hadoop 2108 Feb 22 08:55 logback.xml -rw-r--r-- 1 hadoop hadoop 1367 Feb 22 08:55 logger.xml -rw-r--r-- 1 hadoop hadoop 7167 Feb 22 08:55 routes [hadoop@ambigdata1 conf]$ vim application.conf

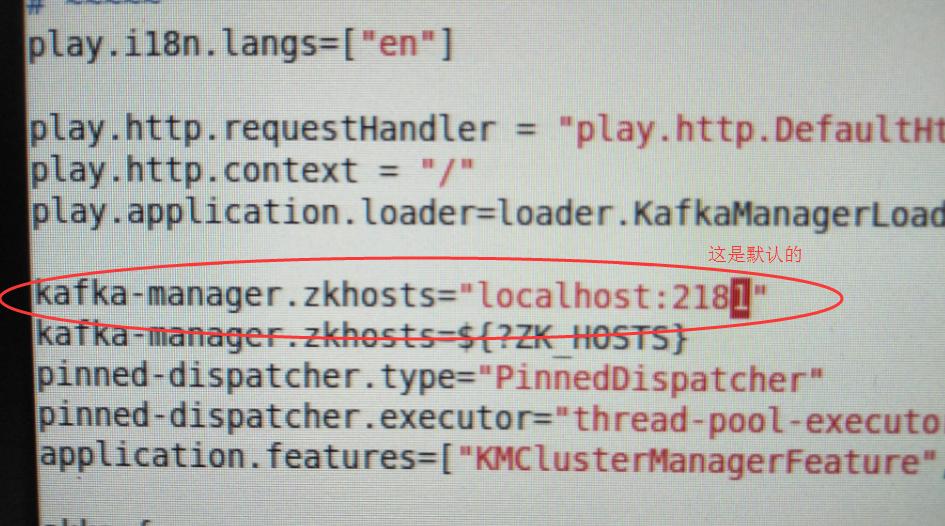

这是默认的

# Copyright 2015 Yahoo Inc. Licensed under the Apache License, Version 2.0 # See accompanying LICENSE file. # This is the main configuration file for the application. # ~~~~~ # Secret key # ~~~~~ # The secret key is used to secure cryptographics functions. # If you deploy your application to several instances be sure to use the same key! play.crypto.secret="^<csmm5Fx4d=r2HEX8pelM3iBkFVv?k[mc;IZE<_Qoq8EkX_/7@Zt6dP05Pzea3U" play.crypto.secret=${?APPLICATION_SECRET} # The application languages # ~~~~~ play.i18n.langs=["en"] play.http.requestHandler = "play.http.DefaultHttpRequestHandler" play.http.context = "/" play.application.loader=loader.KafkaManagerLoader kafka-manager.zkhosts="localhost:2181" kafka-manager.zkhosts=${?ZK_HOSTS} pinned-dispatcher.type="PinnedDispatcher" pinned-dispatcher.executor="thread-pool-executor" application.features=["KMClusterManagerFeature","KMTopicManagerFeature","KMPreferredReplicaElectionFeature","KMReassignPartitionsFeature"] akka { loggers = ["akka.event.slf4j.Slf4jLogger"] loglevel = "INFO" } basicAuthentication.enabled=false basicAuthentication.username="admin" basicAuthentication.password="password" basicAuthentication.realm="Kafka-Manager" kafka-manager.consumer.properties.file=${?CONSUMER_PROPERTIES_FILE}

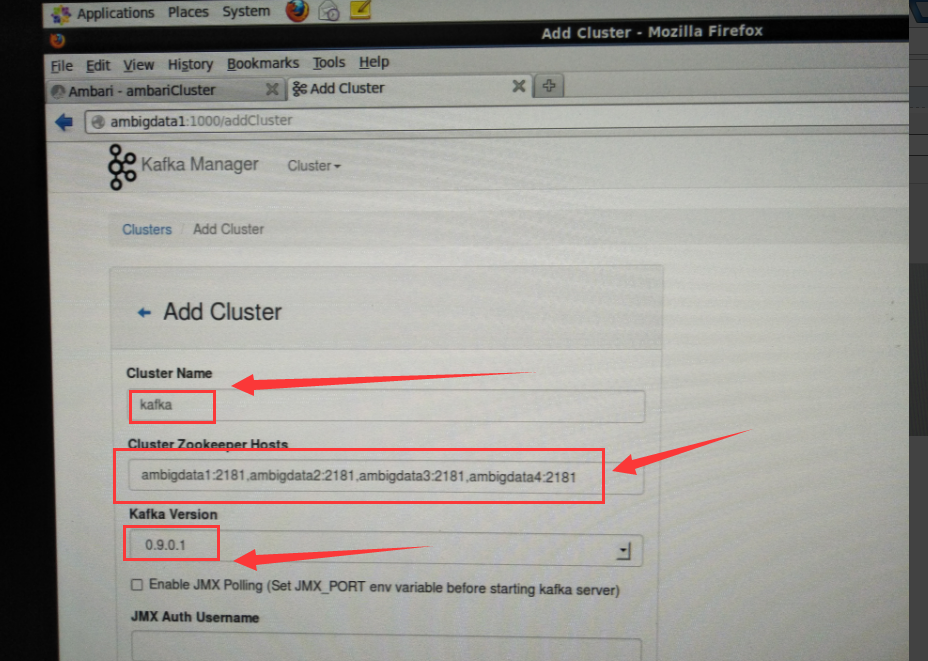

kafka-manager.zkhosts="ambigdata1:2181,ambigdata2:2181,ambigdata3:2181,ambigdata4:2181"

运行kafka manager

注意:默认启动端口为9000。

要到大家kafka-manager的安装目录下来执行。

如我这里是在/usr/hdp/2.4.0.0-169/kafka-manager-1.3.2.1

bin/kafka-manager -Dconfig.file=conf/application.conf

或者

nohup bin/kafka-manager -Dconfig.file=conf/application.conf & (后台运行)

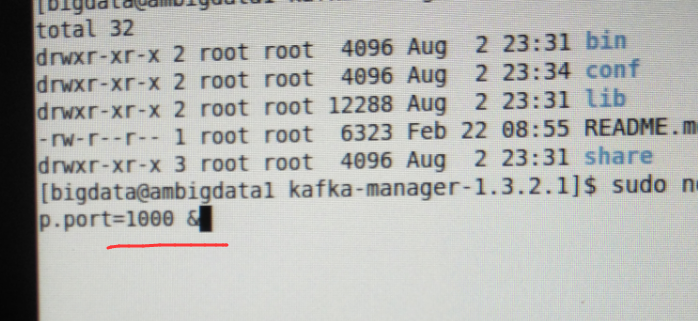

当然,大家可以以这个端口为所用,大家也可以在启动的时候,开启另一个端口,比如我这里开启1000端口。

最好使用绝对路径。

要到大家kafka-manager的安装目录下来执行。

如我这里是在/usr/hdp/2.4.0.0-169/kafka-manager-1.3.2.1

nohup bin/kafka-manager -Dconfig.file=/usr/hdp/2.4.0.0-169/kafka-manager-1.3.2.1/conf/application.conf -Dhttp.port=1000 &

我这里, 为了避免跟ambari集群里默认的oozie端口为10000。所以特地开启1000端口。

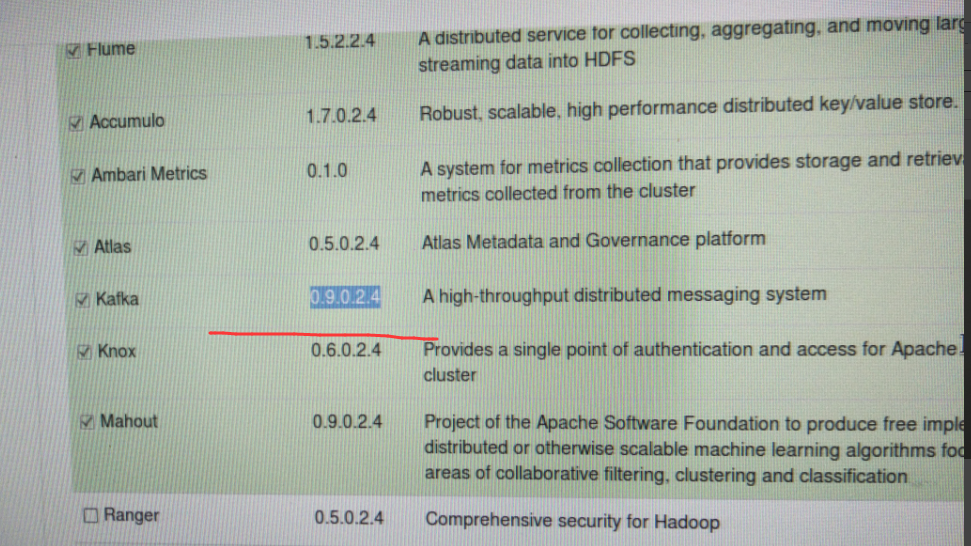

它会自动识别出,当前,你所用的kafka版本

点击【Go to cluster view.】打开当前的集群界面。

成功!

更详细见,

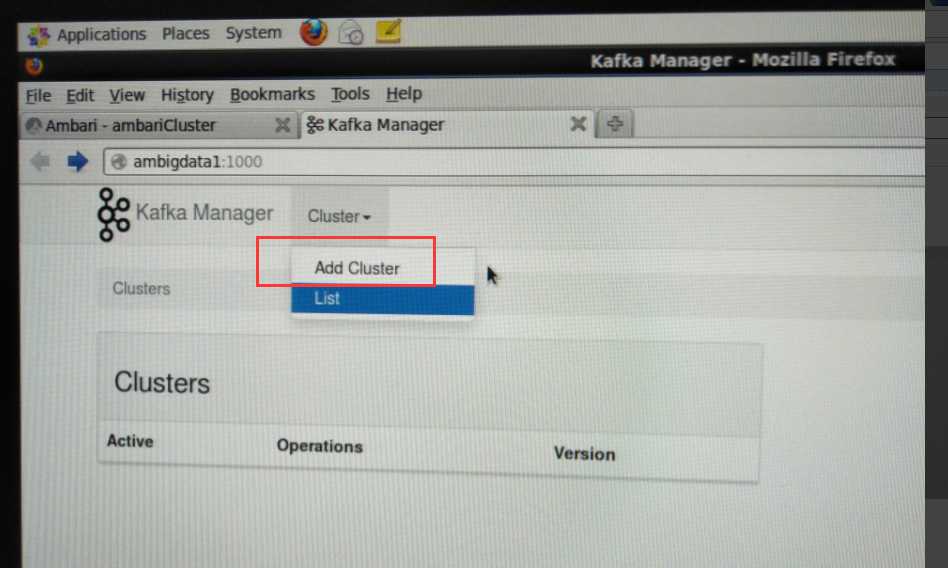

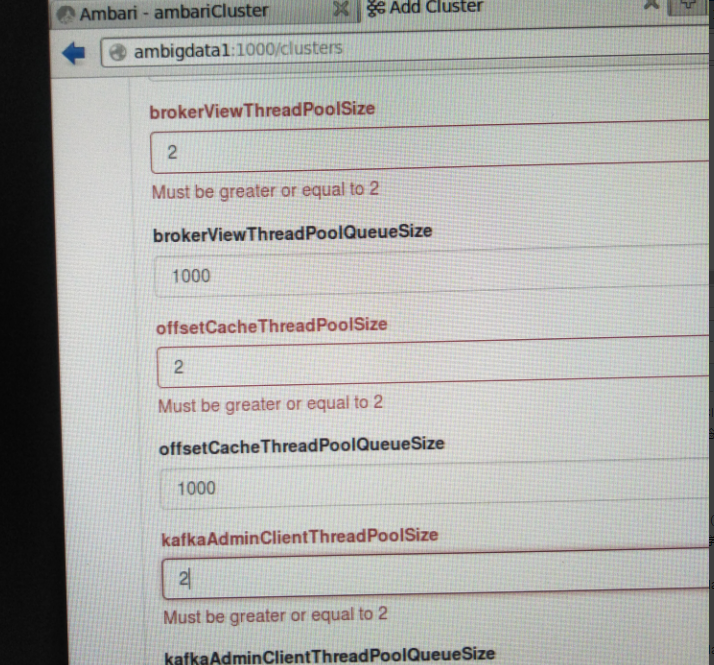

基于Web的Kafka管理器工具之Kafka-manager安装之后第一次进入web UI的初步配置(图文详解)

同时,大家可以关注我的个人博客:

http://www.cnblogs.com/zlslch/ 和 http://www.cnblogs.com/lchzls/ http://www.cnblogs.com/sunnyDream/

详情请见:http://www.cnblogs.com/zlslch/p/7473861.html

人生苦短,我愿分享。本公众号将秉持活到老学到老学习无休止的交流分享开源精神,汇聚于互联网和个人学习工作的精华干货知识,一切来于互联网,反馈回互联网。

目前研究领域:大数据、机器学习、深度学习、人工智能、数据挖掘、数据分析。 语言涉及:Java、Scala、Python、Shell、Linux等 。同时还涉及平常所使用的手机、电脑和互联网上的使用技巧、问题和实用软件。 只要你一直关注和呆在群里,每天必须有收获

对应本平台的讨论和答疑QQ群:大数据和人工智能躺过的坑(总群)(161156071)