Task4——注意力机制与Seq2seq模型

8.1 注意力机制

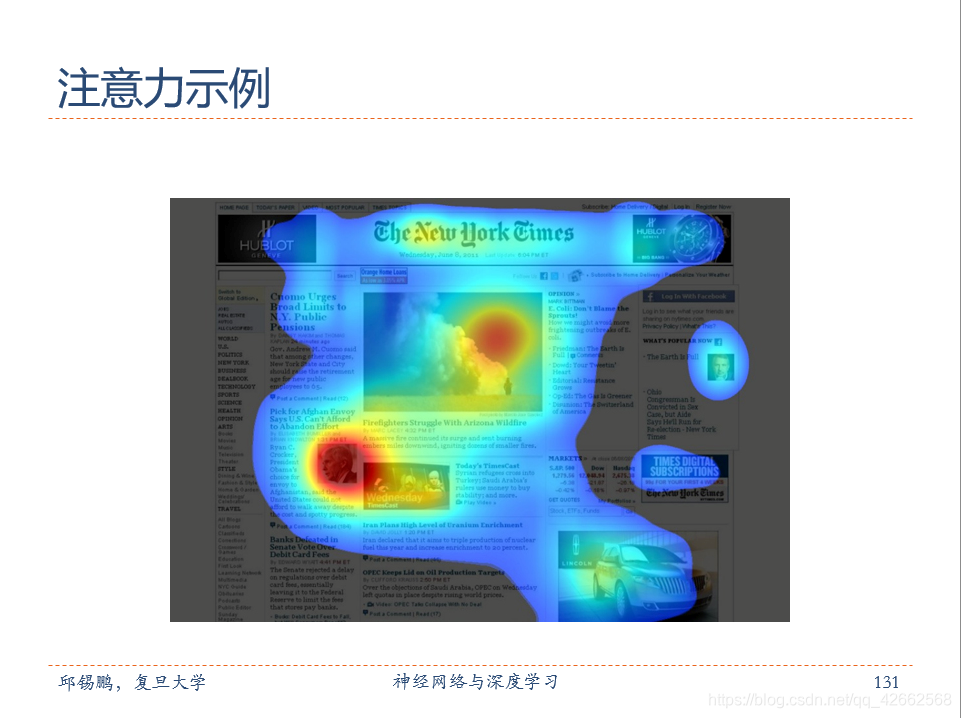

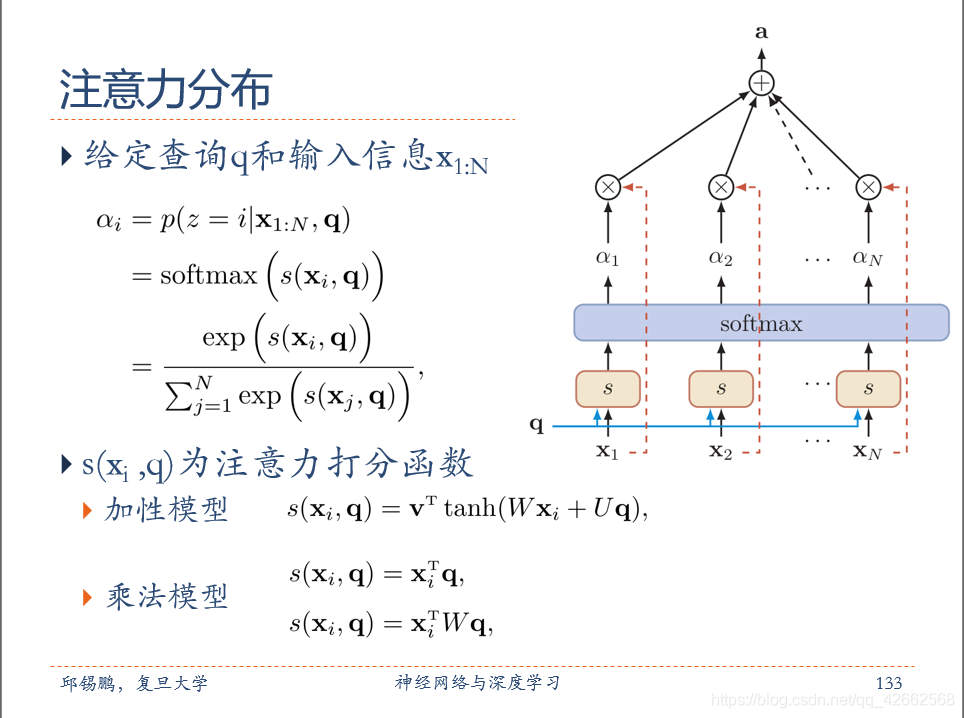

所谓的注意力机制,其实就是让系统学会注意力-即关注重点信息忽略无关信息。带有注意力机制的系统,不仅可以自主学习注意力,还可以帮助我们更好的理解神经网络。现在,在计算机视觉当中大多数都是通过掩码来生成注意力,掩码本质上是一组新的权重,可以帮助我们找到需要关注的信息。

目前主要演化出了两种注意力,一种是软注意力,其重点关注的是区域或通道,这种注意力是固定的,可微的;另一种是强注意力,其重点关注的是点,不可微,一般通过强化学习获得。

当我们人类在看东西时,一般会将注意力集中注视着某个地方,而不会关注全部所有信息。例如当我们一看到下面这张猫的图片时,主要会将目光停留在猫的脸部,以及留意猫的躯干,而后面的草地则会被当成背景忽略掉,也就是说我们在每一处空间位置上的注意力分布是不一样的。

通过这种方式,人类在需要重点关注的目标区域,会投入更多的注意力资源,以获取更多的细节信息,而抑制其它区域信息,这样使人类能够利用有限的注意力资源从大量信息中快速获取到高价值的信息,极大地提升了大脑处理信息的效率。

那么人类的这种“注意力机制”是否可用在AI中呢?

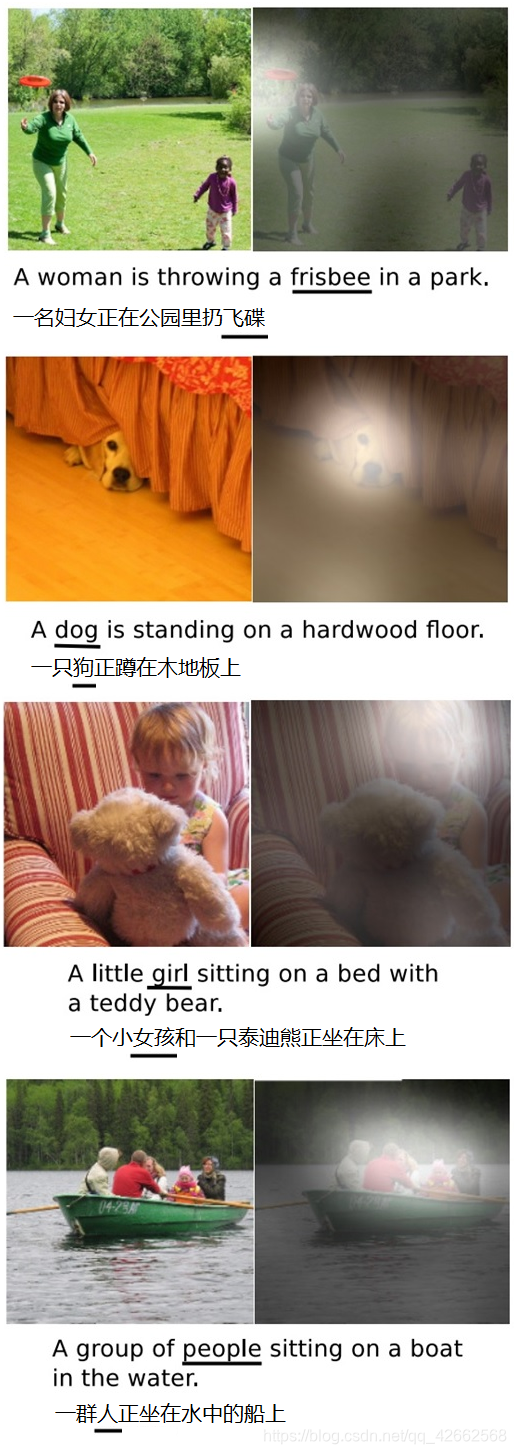

我们来看一下,图片描述(Image Caption)中引入了“注意力机制”后的效果。“图片描述”是深度学习的一个典型应用,即输入一张图片,AI系统根据图片上的内容输出一句描述文字出来。下面看一下“图片描述”的效果,左边是输入原图,下边的句子是AI系统自动生成的描述文字,右边是当AI系统生成划横线单词的时候,对应图片中聚焦的位置区域,如下图:

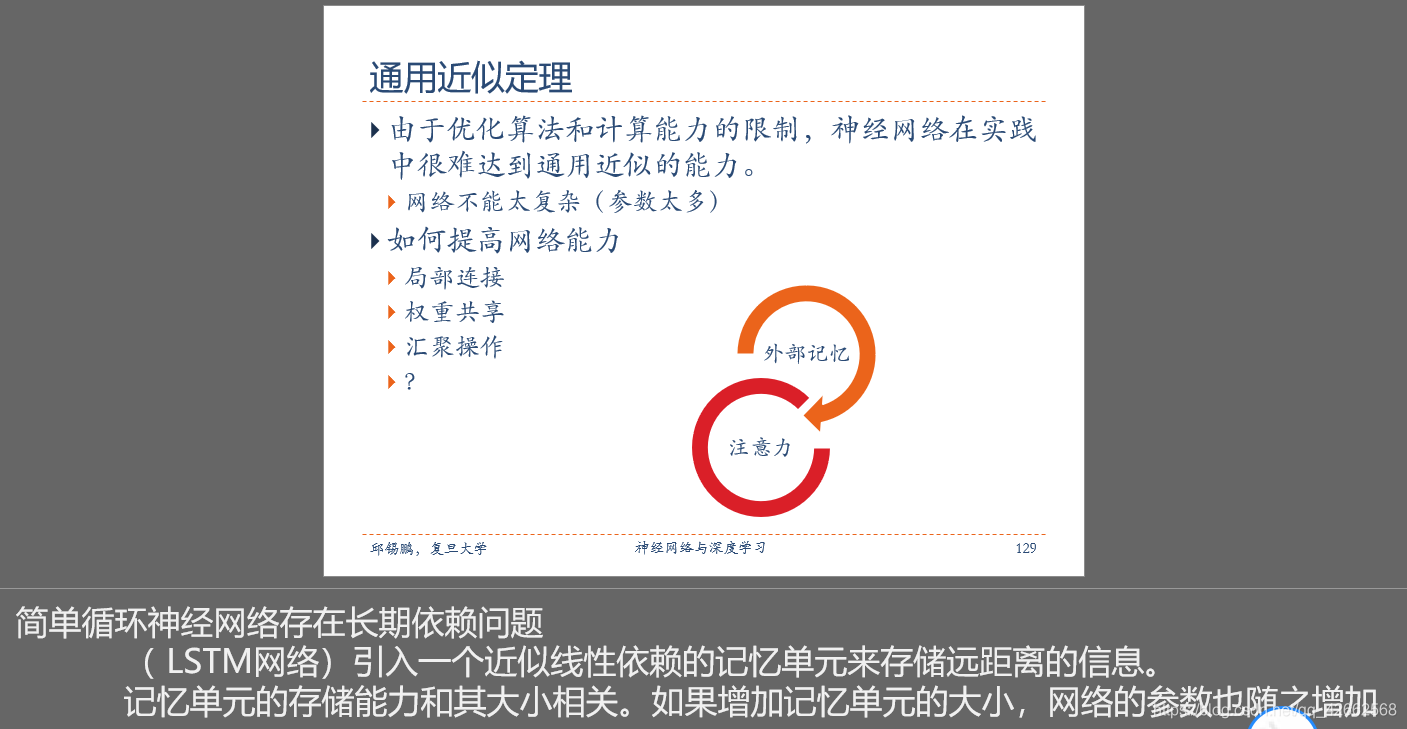

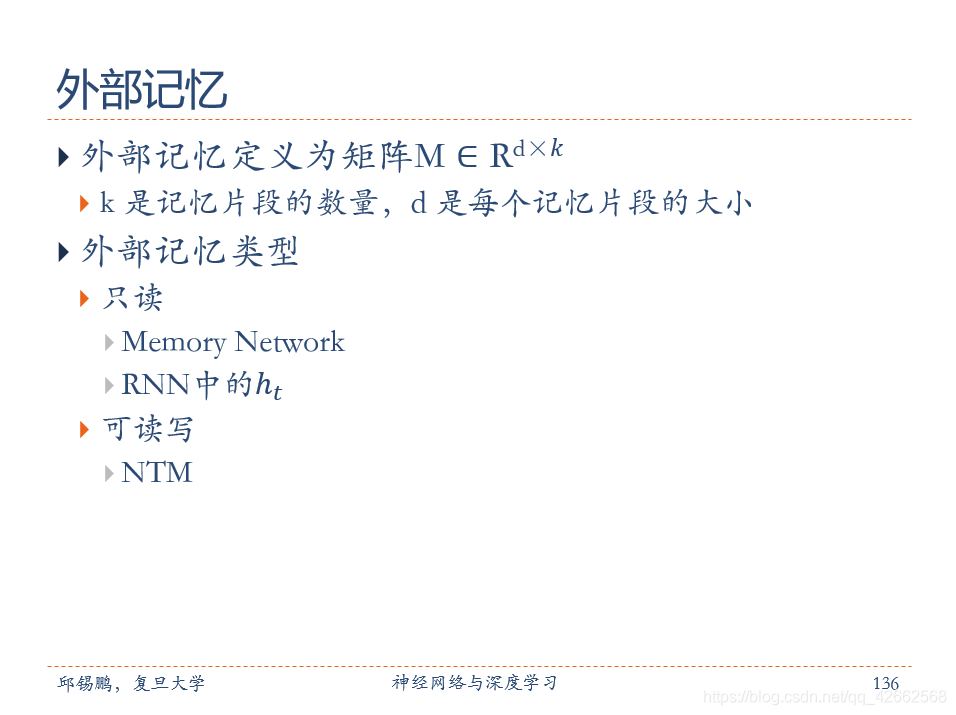

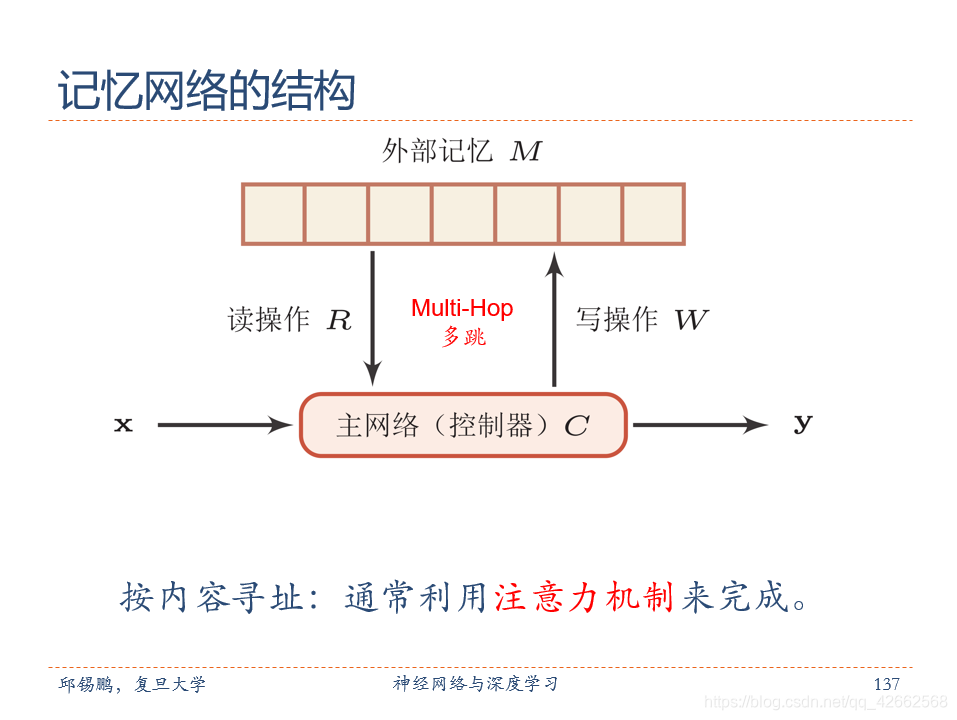

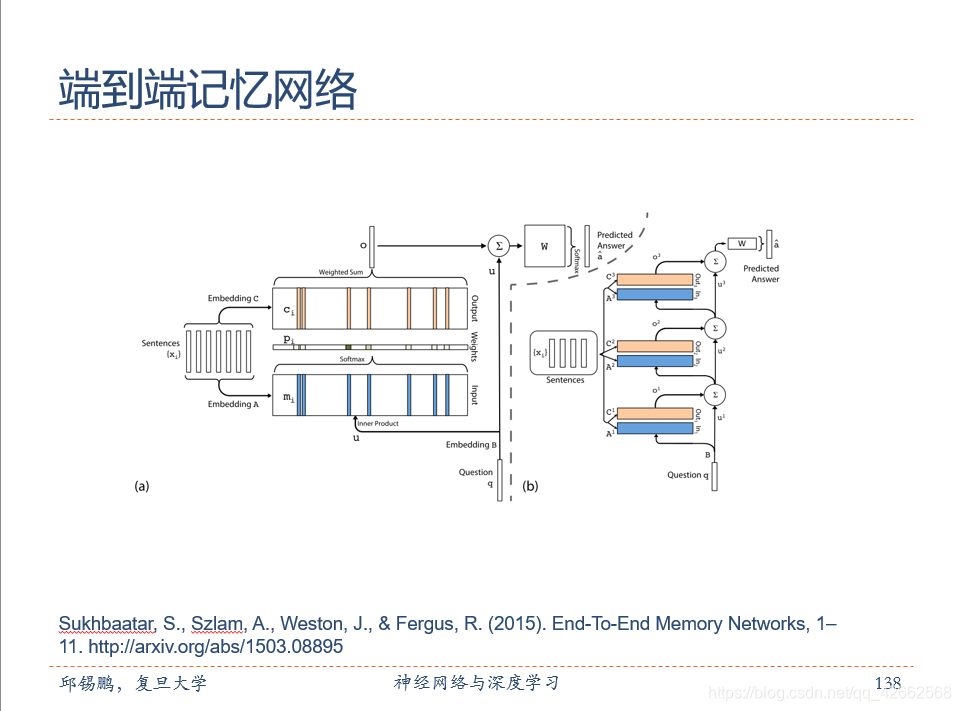

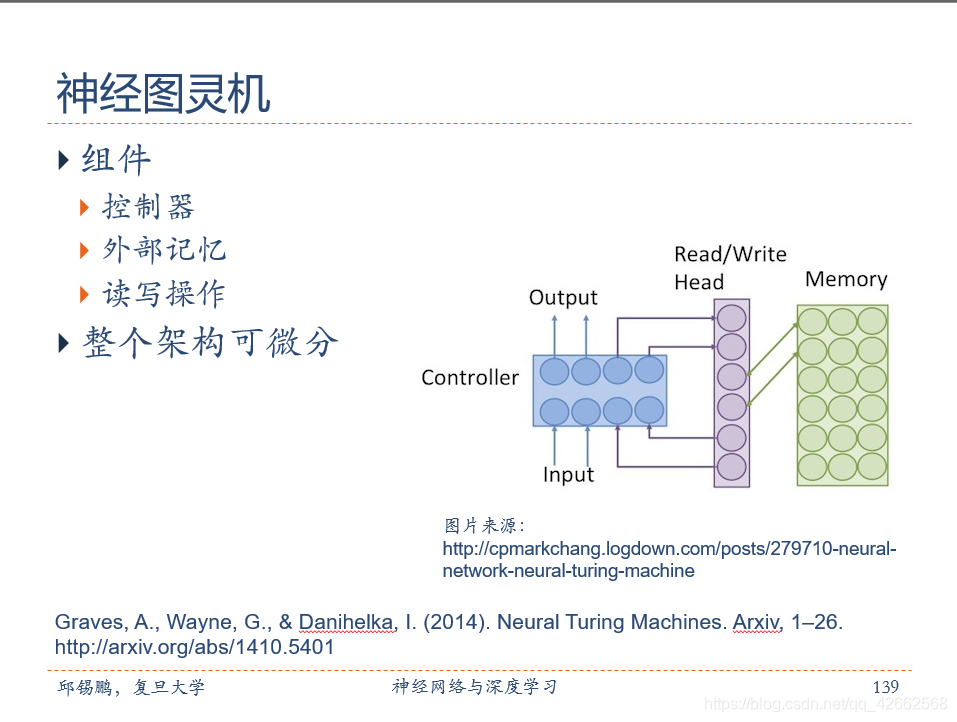

附上复旦大学邱希鹏老师神经网络与深度学习的PPT:

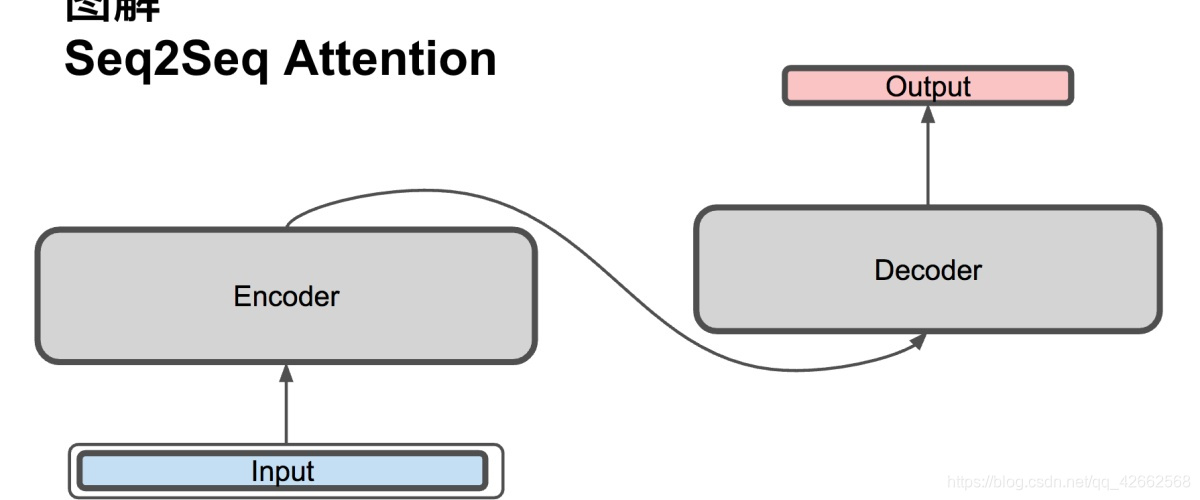

8.2 Seq2seq模型

原文链接:https://zhuanlan.zhihu.com/p/40920384

参考的一篇文章,备用于自己学习,大神写的非常好!

参考内容

[1] 神经网络与深度学习.

[2] 大话注意力机制.