论文地址:一种用于语音带宽扩展的深度神经网络方法

论文作者:Kehuang Li;Chin-Hui Lee

代码地址:github

博客作者:凌逆战

博客地址:https://www.cnblogs.com/LXP-Never/p/10932353.html

摘要

本文提出了一种基于深度神经网络(DNN)的语音带宽扩展(BWE)方法。利用对数谱功率作为输入输出特征进行所需的非线性变换,训练神经网络来实现这种高维映射函数。在10小时的大型测试集上对该方法进行评估时,我们发现与传统的基于高斯混合模型(GMMs)的BWE相比,DNN扩展语音信号在信噪比和对数谱失真方面具有很好的客观质量度量。在假定相位信息已知的情况下,主观听力测试对DNN扩展语音的偏爱度为69%,对GMM的偏爱度为31%。对于实际运行中的测试,当相位信息从给定的窄带信号imaged(成像)时,首选项的比较上升到84%,而不是16%。正确的相位恢复可以进一步提高该方法的BWE性能。

关键词:深度神经网络,语音带宽扩展,频谱映射,相位估计

1 引言

将语音带宽从窄带(4khz带宽)扩展到宽带(8khz带宽)已经研究了几十年,因为带宽在早期是一种昂贵的资源。即使现在语音传输的带宽不再受到紧张的限制,我们在现有的公共交换电话网(PSTN)系统中仍然面临着低带宽的限制。为了提高语音在PSTN上的收听质量,人们一直在努力人为地扩展带宽。

早期对带宽扩展(BWE)的研究多集中于估计高频带的频谱包络线,利用低频带产生的激励恢复高频频谱[1]。早期工作探讨了线性映射[2]、分段线性映射[3,4]、码本映射[5,6]、神经网络[7,8]、高斯混合模型[9,10]、隐马尔可夫模型[11,12]和非负隐马尔可夫模型[13]等技术。线性预测系数(LPCs)或线谱频率(LSFs)[14,15]被广泛用于表示频谱包络,而激励可以通过LPCs对信号进行反滤波、调制技术、非线性处理以及函数生成器[1]的应用来发现。

与包络估计方法相比,由于建立原始低频频谱和目标高频频谱映射函数的的维度都很高,因此对缺失高频频谱的直接估计没有得到广泛的研究。然而,目前仍有一些研究,如折叠频谱调整[8]和稀疏概率状态映射[16]。前者对窄带频谱进行折叠,调整宽带频谱的水平,尝试以不同的方式估计频谱包络线。后者假设映射的传输矩阵是稀疏的,这通常是不准确的。然而,这些技术表明,直接估计缺失带的频谱具有一定的优势,值得进一步研究。

综上所述,我们建议使用DNN进行频谱映射来估计缺失的高频频谱。在10小时的大型测试集上进行的实验表明,与传统的基于GMM的映射技术相比,提出的DNN框架在分段信噪比[17]和对数谱失真[18]方面具有更好的客观测量效果。当相位信息是已知的,主观偏好听力测试也给出69%的分数,而GMM的偏好评分是31%。对于实际运行测试,当相位信息从给定的窄带信号成像时,首选项的比较上升到84%,GMM是16%。正确的相位恢复可以进一步提高所提出的DNN方法的BWE性能。

2 基于DNN的语音频带扩展

2.1 特征提取

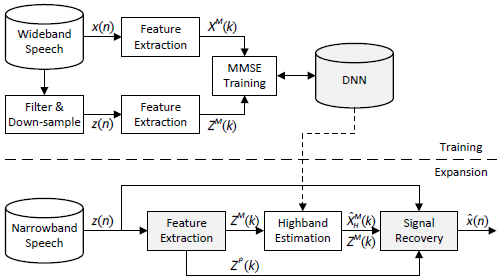

图1 提出的DNN-BWE系统框图

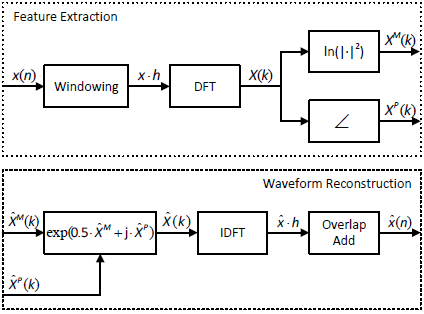

图2 特征提取和波形重建的流程图

图1给出了基于DNN的BWE系统的框图。给定一个宽带语音信号x,我们将其加窗口得到重叠帧,并在加窗后的语音帧上执行短时傅里叶变换(STFT) [19],

$$公式1:X(l,k)=sum_{n=0}^{N-1}x(l*Delta +n)h(n)e^{frac{-j2pi nk}{N}}$$

其中$l$为帧索引,$k=0,...,L-1$为离散频率索引,$Delta$为窗移,N为窗长,$h(·)$为窗函数,这里为汉明窗。我们将在文章的其余部分省略$l$,因为我们将重点放在每帧语音的特征上。提取对数谱功率值[20]

$$公式2:X^M(k)=In|X(k)|^2$$

因为$x$是一个真实信号,$X$是共轭对称的,仅由$frac{N}{2}+1$点决定。因此,我们使用$k=0,...,frac{N}{2}$的$X^M(k)$作为特征。对于宽带信号,进一步将$X^M$分为低频谱$X_L^M=[X^M(0),...,X^M(frac{N}{4})]$,高频谱$X_H^M=[X^M(frac{N}{4}+1),...,X^M(frac{N}{2})]$,其中$X_H^M$由DNN根据窄带(低频)谱恢复。

除傅里叶系数的大小外,相位信息提取如下

$$公式3:X^P(k)=angle X(k)$$

对于宽带信号,将$X^P$按其对应的$X^M$大小分别分解为$X_L^P$和$X_H^P$。

对宽带信号$x$进行滤波和降采样,得到窄带信号对应的对数谱幅值和相位$z$,$Z^M$和$Z^P$。

2.2 DNN训练

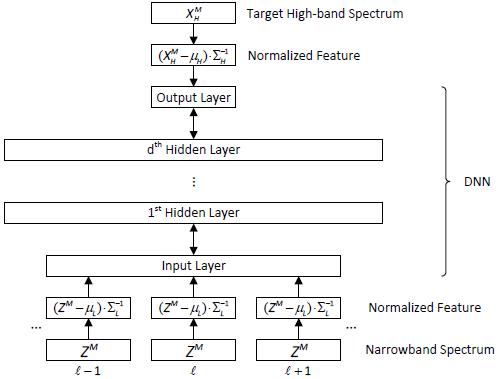

如图3所示,DNN的输入为窄带信号的对数谱,输出为宽带信号的高频对数谱。为了保证神经网络的正常工作,对所有训练样本的神经网络输入输出的各个维度进行归一化处理,保证其均值为零,方差为1。因此,在带宽扩展的应用阶段,需要对输入特征向量执行相同的归一化操作,对输出执行相反的操作。

我们使用Kaldi工具包[21]来训练DNNs。首先对受限玻尔兹曼机(RBM)进行无监督预训练。然后,在判别微调中,采用最小均方误差准则(MMSE),试图使预测的高频对数谱与期望宽带信号的真实高频对数谱之间的欧氏距离最小化。设Y为DNN的输出,MMSE的目标函数为

$$公式4:minfrac{1}{2}||(X_H^M-mu_H)sum_H^{-1}-Y||_2^2$$

其中$mu_H$和$sum_H^{-1}$为训练数据所有高频对数谱的均值向量和对角逆协方差矩阵。

图3 DNN架构和训练

2.3 波形重建

即使可以精确的获得宽带频谱的大小,在前面的步骤中也会丢失相位信息。DNN模型输出的是高频频谱估计$hat{X}_H^M=(Y+mu_H)sum_H$,因此我们可以计算出扩展的宽带频谱估计:$hat{X}^M=[Z^M+2In2,hat{X}_H^M]$,其中$2In2$补偿了由于仅使用宽带信号的一半点来计算窄带频谱而引起的能量损失。为了防止的质量下降,窄带谱不做修改[7]。对于相位,我们对低频相位$hat{X}_L^P=Z^P$进行了估计,高频相位未知。Imaged(成像)相位是一个简单的估计$hat{X}^P=[Z^P,-flip(Z^P)]$,其中$flip(Z^P)$,或简称为$Z_F^P$,定义为$k-0,1...,frac{N}{4}-1$时$Z_F^P(k)=Z^P(frac{N}{4}-1-k)$。然后进行了离散傅里叶反变换(IDFT)

$$公式5:hat{X}(k)=exp{frac{1}{2}hat{X}^M(k)+jhat{X}^P(k)}$$

反转步骤(2)和(3),用[23]中给出的重叠加法和相同的汉明窗进行特征提取重建信号$hat{x}$。

3 实验与结果

3.1 实验步骤

我们在华尔街日报(WSJ0)语料库[24]上进行了实验,在16位分辨率下以16KHz采样率采样的麦克风语音。与其他技术进行直接比较并不容易。相反,我们在WSJ0上进行了大规模的测试,训练集中有31166条话语(训练约50小时,验证约10小时),测试4137条话语(约10小时)。STFT的窗口大小为512个样本,在宽带信号上的偏移长度为256个样本,而窄带信号的窗口大小为256,偏移量为128。将MMSE训练的基本学习率设置为$10^{-5}$,采用"newbob"方法[25],当均方误差减小到小于0.1时学习率减半,当均方误差减小到小于0.01停止。采用小批量训练[26],批量大小为32个话语。作为比较,我们建立了2045种混合的全协方差GMM模型,并利用该模型进行了与DNN相同的回归分析。

3.3.1 客观质量度量

本实验采用的客观质量指标为分段信噪比[17](segmental SNR, SegSNR)和对数频谱失真(log-spectrum distortion,LSD)[18],定义如下

$$公式6:SegSNR=frac{1}{L}sum_{l=0}^{L-1}{10lgfrac{sum_{n=0}^{N-1}[x(l,n)]^2}{sum_{n=0}^{N-1}[x(l,n)-hat{x}(l,n)]^2}}$$

其中$l$表示第$l$帧,L表示语音中的帧数。

$$公式7:LSD=frac{1}{L}sum_{l=0}^{L-1}{{frac{1}{frac{N}{2}+1}}sum_{k=0}^{frac{N}{2}}[X^M(l,k)-hat{X}^M(l,k)]^2}^{frac{1}{2}}$$

为了测量高频段频谱估计的性能,我们还引入了$LSD_H$,我们还引入了仅用离散频率指数求和高半带失真的$LSD_H$,$k=|frac{N}{4}+1,...,frac{N}{2}$。

3.1.2 主观测试

除上述客观测量外,还进行了主观听力测试。10名志愿者被要求随机听10对测试话语,他们的偏好被记录下来并总结出来,以表明总体偏好。

3.2 结果与讨论

3.2.1 DNN结构

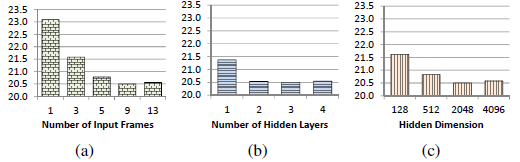

神经网络的大小和形状会影响神经网络的性能。为了简单起见,我们将重点放在DNN中具有相同宽度的隐藏层上。我们采用了[27]中的结构设置。如图4所示,在我们对WSJ0数据集的实验中,具有9帧、3个隐层和每层2048个隐层节点的DNN是一个局部最优的参数设置。这里9帧表示将4个前帧和4个后帧与当前帧 连接到DNNs的输入层。结果表明,该性能对小参数差异不敏感。

图4 不同DNNs的MSE。默认参数为9帧、3层和每层2048个隐藏节点,每次比较只有一个参数是变化的

3.2.2 客观表现

表1列出了不同方法和相位重构信号的分段信噪比和LSD结果。每个方法的第一行是CP,表示我们使用了“cheated phase(欺骗相位)”,即,我们使用的是在输入窄带信号时不可用的原宽带信号的高半带相位。每一种方法的第二行是IP,表示使用了“Imaged phase”,即,我们将输入窄带信号的相位翻转到上半带,并给它们加上一个负号。与传统的想法相反,如果使用不正确的相位进行重构,重构信号的分段信噪比会大大降低(GMM从15.42 dB降至12.12 dB, DNN从16.47 dB降至12.78 dB)。被欺骗相位的LSD始终比Image phase的LSD好1 dB以上。对于高频段的LSD,在约$1.3dB~2dB$左右的衰减情况下,始终比整个频段的LSD更为严重。此外,DNN在CP和IP案例以及所有三项指标上都优于GMM。

表1 对重构信号的客观度量

| SegSNR(dB) | LSD(dB) | $LSD_H$(dB) | ||

| GMM | CP | 15.42 | 6.34 | 8.28 |

| IP | 12.12 | 7.29 | 9.72 | |

| DNN | CP | 16.47 | 5.32 | 6.69 |

| IP | 12.78 | 6.44 | 8.44 |

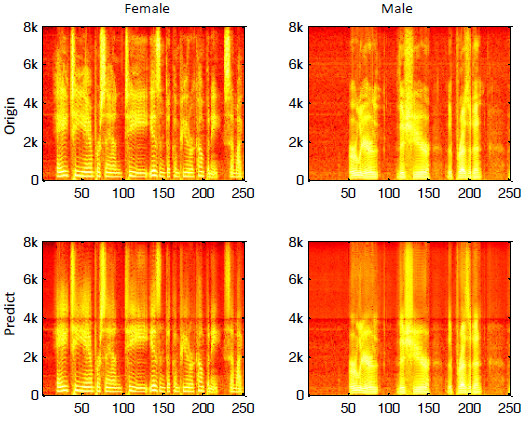

图5给出了一个女性和一个男性测试话语的例子。直接预测高频频谱的一个问题是低频频谱与高频频谱之间存在不连续。

图5:。一个女性测试话语和一个男性测试话语的语谱图,顶行:原始,底行:重构信号,左列:女性,右列:男性。

3.2.3 主观表现

当与窄带信号竞争时,GMM和DNN都有100%的优势。表2显示了GMM和DNN之间的竞争结果。在相位信息已知的情况下,他们对GMM扩展语音给出了69%的评分,高于31%。对于实际操作测试,当从给定窄带信号成像相位信息时,首选项的比较上升到84%,而不是16%。良好的相位估计信息可以进一步提高所提出的DNN方法的BWE性能。

表2 重构信号的测试表现

| CP | IP | |

| GMM | 31% | 16% |

| DNN | 69% | 84% |

3.2.4 计算复杂度比较

我们的实验使用一台32 2.93 GHz CPU核和一张GTX480显卡的工作站。表3为DNN和GMM在训练和扩展阶段的计算时间。测试数据本身的大小约为600分钟,即扩展阶段可以实时进行。然而,DNNs的延迟时间取决于参数设置。使用上述实验设置,lag time(滞后时间)为96 ms((4帧移位* 128点/移位+ 1当前帧* 256点/帧)/ 8 kHz)。

表3 训练和测试的时间消耗

| Train | Test | |

| DNN | 1501 min | 93 min |

| GMM | 358 min | 367 min |

4. 结论及未来工作

提出了一种基于深度神经网络的语音带宽扩展框架。利用深度学习能力,DNN能够将输入窄带信号的幅度谱映射到宽带信号的高频段。实验结果表明,与基于GMM的BWE方法相比,本文提出的DNN框架能够有效地估计高频频谱,获得更高的分段信噪比和更低的对数谱失真。主观测试也证实了我们提出的框架比其他基于GMM的系统表现出更高的听力偏好。对于进一步的工作,我们打算处理图5中提到的频谱不连续问题。此外,通过正确的相位恢复,我们观察到系统性能可以进一步提高,这将在另一篇即将发表的论文中进行研究。

5 参考文献

[1] B. Iser and G. Schmidt, “Bandwidth extension of telephony speech,” in Speech and Audio Processing in Adverse Environments,pp. 135–184. Springer, 2008.

[2] Y. Nakatoh, M. Tsushima, and T. Norimatsu, “Generation of broadband speech from narrowband speech based on linear mapping,” Electronics and Communications in Japan (Part II:Electronics), vol. 85, no. 8, pp. 44–53, 2002.

[3] Y. Nakatoh, M. Tsushima, and T. Norimatsu, “Generation of broadband speech from narrowband speech using piecewise linear mapping,” in Proc. EUROSPEECH, 1997, pp. 1643–1646.

[4] J. Epps and W. H. Holmes, “A new technique for wideband enhancement of coded narrowband speech,” in Proc. IEEE Workshop on Speech Coding, 1999, pp. 174–176.

[5] U. Kornagel, “Spectral widening of telephone speech using an extended classification approach,” in Proc. EUSIPCO, 2002,vol. 2, pp. 339–342.

[6] S. Vaseghi, E. Zavarehei, and Q. Yan, “Speech bandwidth extension: extrapolations of spectral envelop and harmonicity quality of excitation,” in Proc. ICASSP, 2006, vol. 3.

[7] B. Iser and G. Schmidt, “Neural networks versus codebooks in an application for bandwidth extension of speech signals,” in Proc. INTERSPEECH, 2003, pp. 565–568.

[8] J. Kontio, L. Laaksonen, and P. Alku, “Neural network-based artificial bandwidth expansion of speech,” IEEE Trans. on Audio,Speech, and Lang. Process., vol. 15, no. 3, pp. 873–881,2007.

[9] K.-Y. Park and H. S. Kim, “Narrowband to wideband conversion of speech using GMM based transformation,” in Proc.ICASSP, 2000, vol. 3, pp. 1843–1846.

[10] H. Seo, H.-G. Kang, and F. Soong, “A maximum a posteriorbased reconstruction approach to speech bandwidth expansion in noise,” in Proc. ICASSP, 2014, pp. 6087–6091.

[11] P. Jax and P. Vary, “Artificial bandwidth extension of speech signals using MMSE estimation based on a hidden Markov model,” in Proc. ICASSP, 2003, vol. 1, pp. I–680.

[12] G.-B. Song and P. Martynovich, “A study of HMM-based bandwidth extension of speech signals” Signal Processing,vol. 89, no. 10, pp. 2036–2044, 2009.

[13] J. Han, G. J. Mysore, and B. Pardo, “Language informed bandwidth expansion,” in Proc. IEEE Workshop on Machine Learning for Signal Processing, 2012, pp. 1–6.

[14] W. P. LeBlanc, B. Bhattacharya, S. A. Mahmoud, and V. Cuperman,“Efficient search and design procedures for robust multi-stage VQ of LPC parameters for 4 kb/s speech coding,”IEEE Trans. Speech Audio Process., vol. 1, no. 4, pp. 373–385,1993.

[15] F. K. Soong and B.-H. Juang, “Optimal quantization of LSP parameters,” IEEE Trans. Speech Audio Process., vol. 1, no. 1,pp. 15–24, 1993.

[16] K. Kalgaonkar and M. A. Clements, “Sparse probabilistic state mapping and its application to speech bandwidth expansion,”in Proc. ICASSP, 2009, pp. 4005–4008.

[17] S. R. Quackenbush, T. P. Barnwell, and M. A. Clements, Objective measures of speech quality, Prentice Hall Englewood Cliffs, NJ, 1988.

[18] I. Cohen and S. Gannot, “Spectral enhancement methods,”in Springer Handbook of Speech Processing, pp. 873–902.Springer, 2008.

[19] J. B. Allen and L. Rabiner, “A unified approach to short-time Fourier analysis and synthesis,” Proc. of the IEEE, vol. 65, no.11, pp. 1558–1564, 1977.

[20] J. Du and Q. Huo, “A speech enhancement approach using piecewise linear approximation of an explicit model of environmental distortions.,” in Proc. INTERSPEECH, 2008, pp.569–572.

[21] D. Povey, A. Ghoshal, G. Boulianne, L. Burget, O. Glembek,N. Goel, M. Hannemann, P. Motlicek, Y. Qian, P. Schwarz,et al., “The Kaldi speech recognition toolkit,” in Proc. ASRU,2011, pp. 1–4.

[22] D. H. Ackley, G. E. Hinton, and T. J. Sejnowski, “A learning algorithm for Boltzmann machines,” Cognitive Science, vol. 9,no. 1, pp. 147–169, 1985.

[23] D. Griffin and J. S. Lim, “Signal estimation from modified short-time Fourier transform,” IEEE Trans. Acoust., Speech,Signal Process., vol. 32, no. 2, pp. 236–243, 1984.

[24] D. B. Paul and J. M. Baker, “The design for the Wall Street Journal-based CSR corpus,” in HLT ’91 Proceedings of the workshop on Speech and Natural Language, 1992, pp. 357–362.

[25] ICSI QuickNet toolbox. Newbob approach is implemented in the toolbox. [Online]. Available:http://www1.icsi.berkeley.edu/Speech/qn.html

[26] G. E. Hinton, “A practical guide to training restricted Boltzmann machines,” Tech. rep. utml tr 2010–003, Dept. Comput.Sci., Univ. Toronto, 2010.

[27] Y. Xu, J. Du, L. Dai, and C.-H. Lee, “An experimental study on speech enhancement based on deep neural networks,” IEEE Signal Process. Lett., pp. 65–68, 2014.