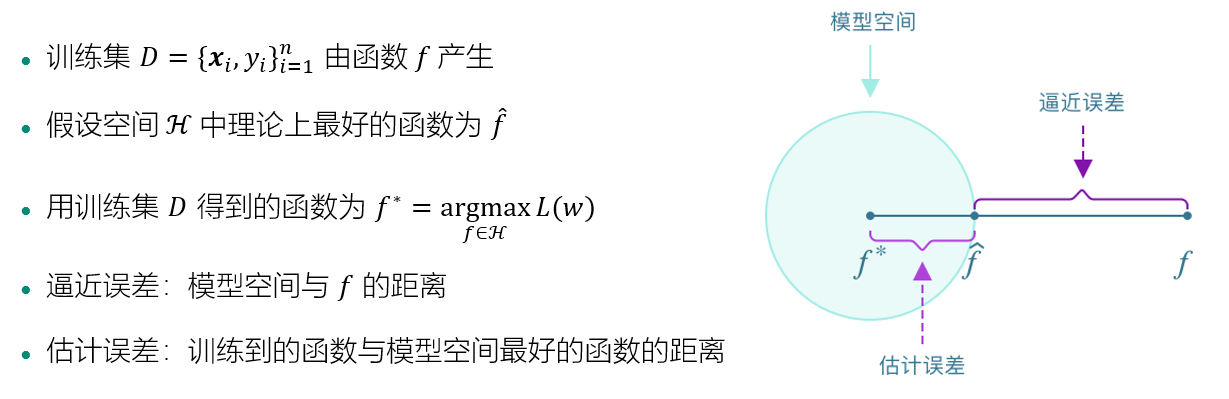

模型误差的来源

非线性模型

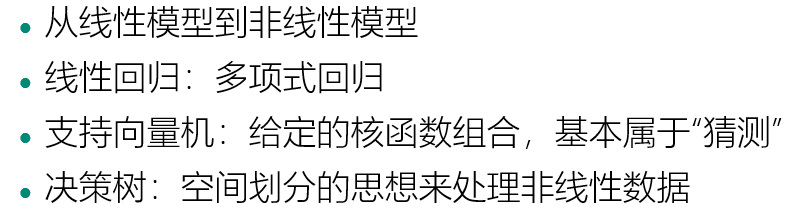

深度学习

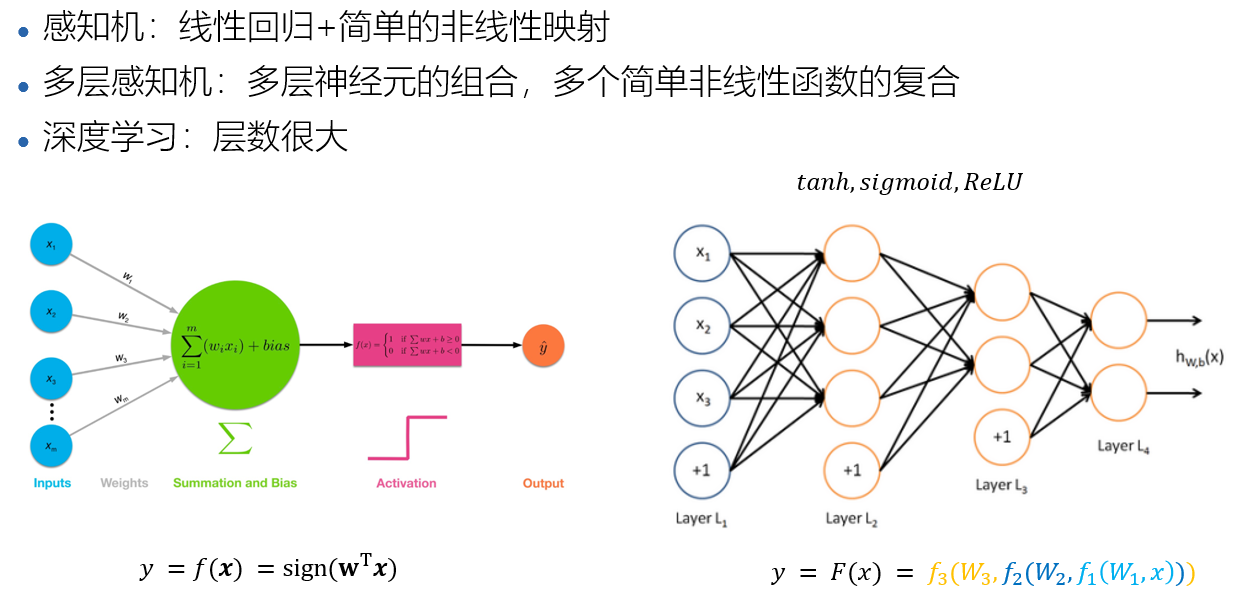

模型集成

为什么能提高效果

- 增强模型的表达能力

- 降低误差

- 假设单个分类器误差p,分类器之间独立,T个分类器采用投票进行预测,得到集成模型H

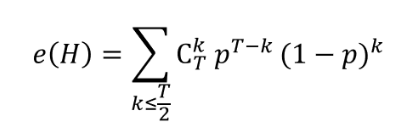

- 集成分类器误差为

- T = 5,p = 0.1时,e(H) =< 0.01

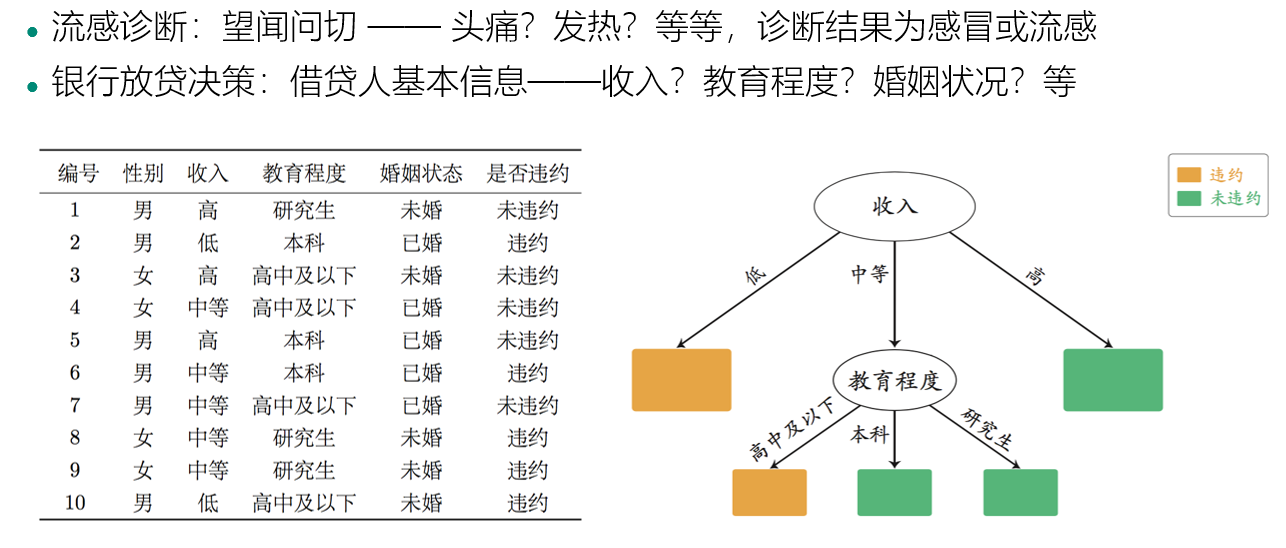

决策树:把问题问到点子上

决策树:空间的方块划分

决策树的生成

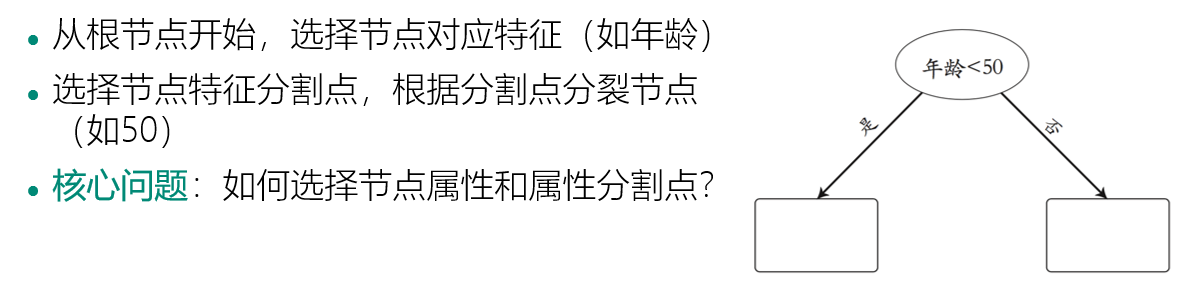

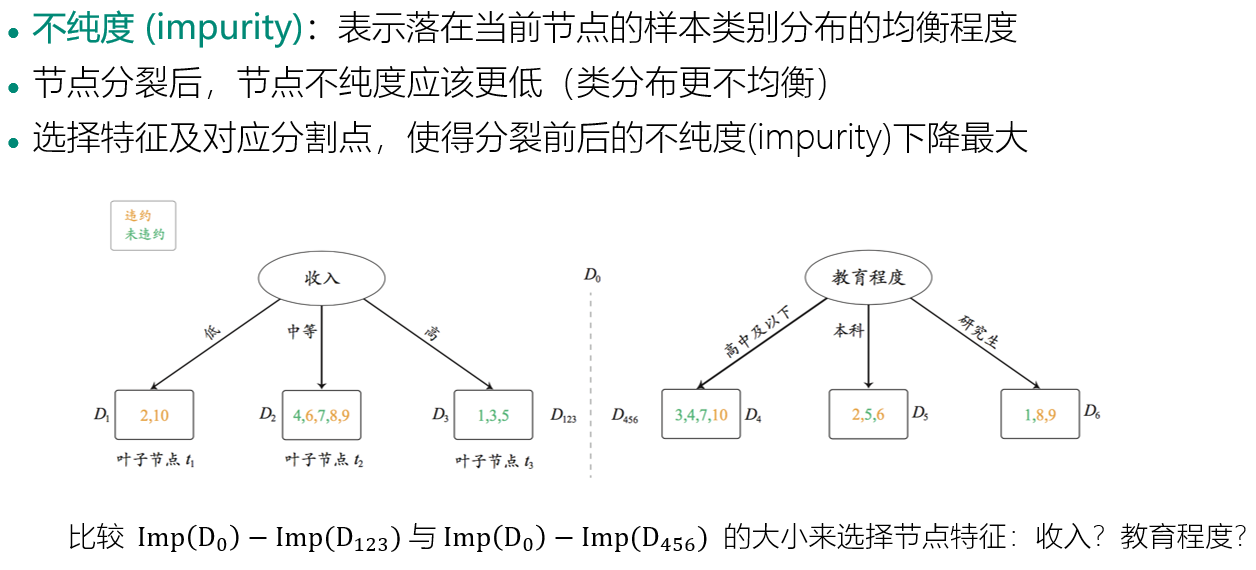

节点特征和分割点的选择

节点不纯度的度量

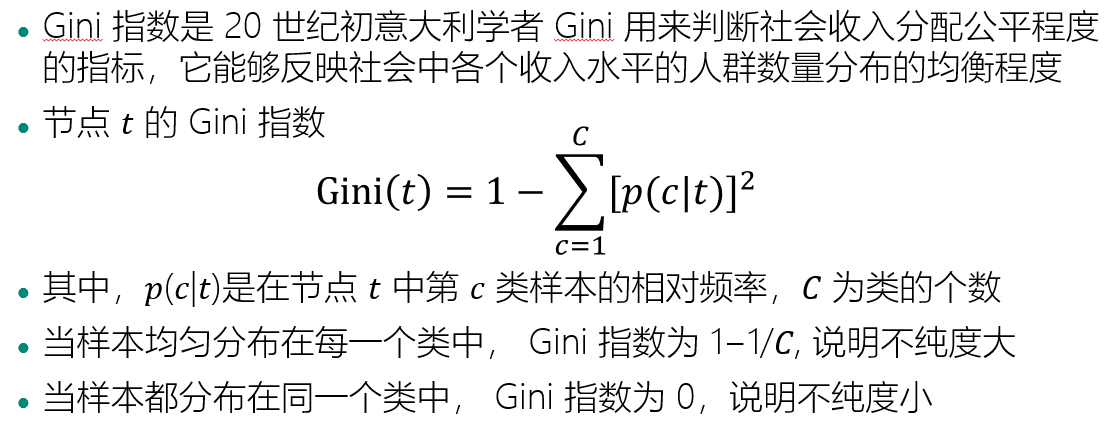

Gini指数

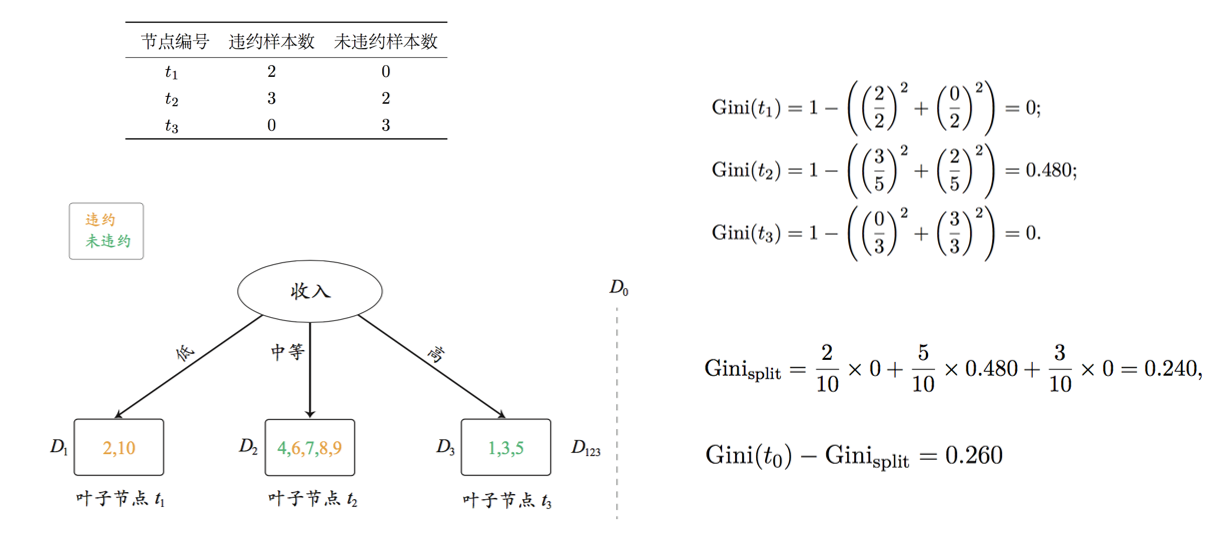

Gini 指数(计算示例)

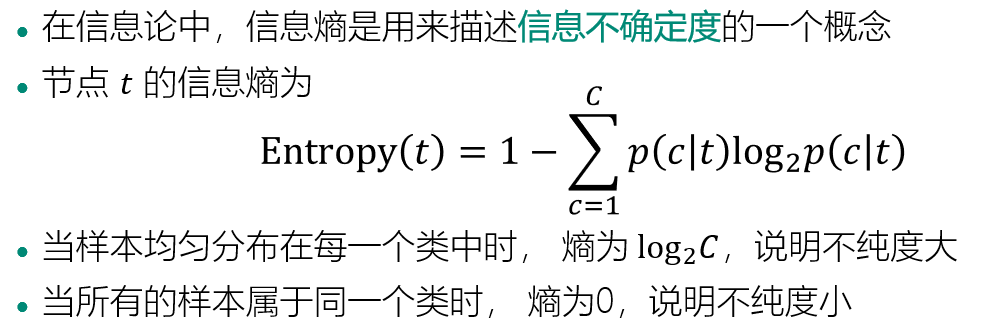

信息熵

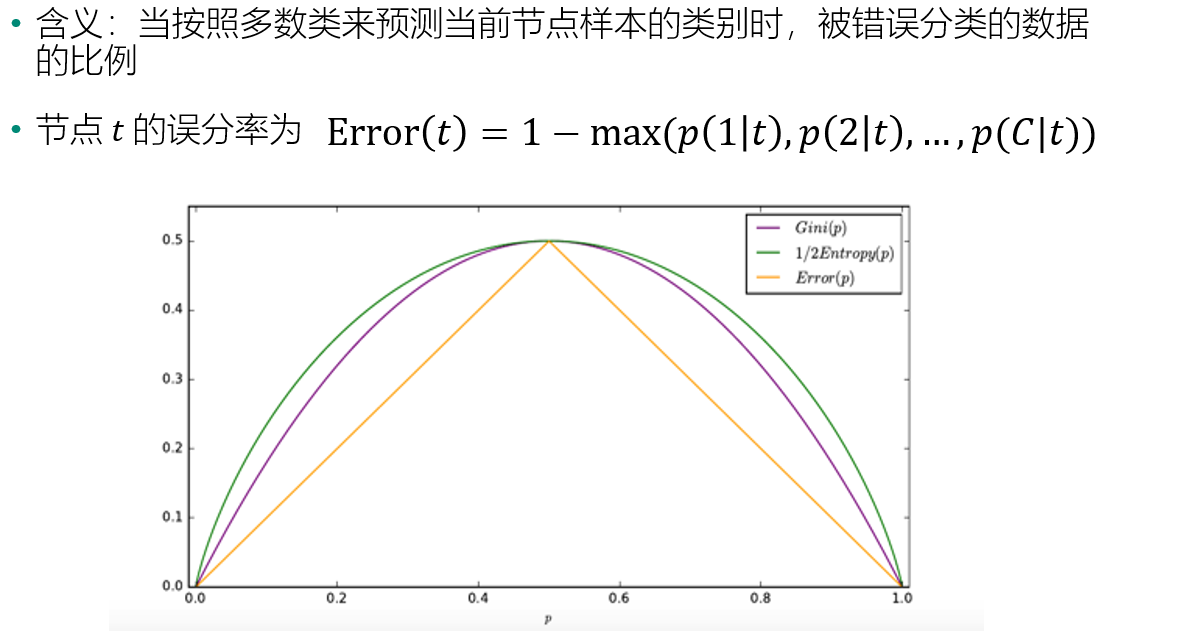

误分率

随机森林:独立思考的重要性

- 最典型的Bagging算法:“随机”是其核心,“森林”意在说明它是通过组合多棵决策树来构建模型

- 主要特点

- 对样本进行有回放抽样

- 对特征进行随机抽样

- 应用场景广泛:例如市场营销、股票市场分析、金融欺诈检测、基因组数据分析和疾病风险预测

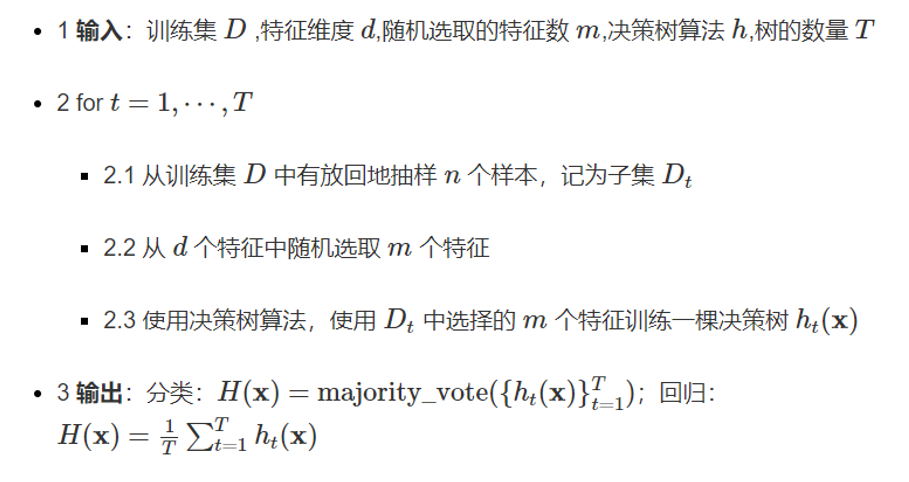

随机森林的算法流程

算法分析:

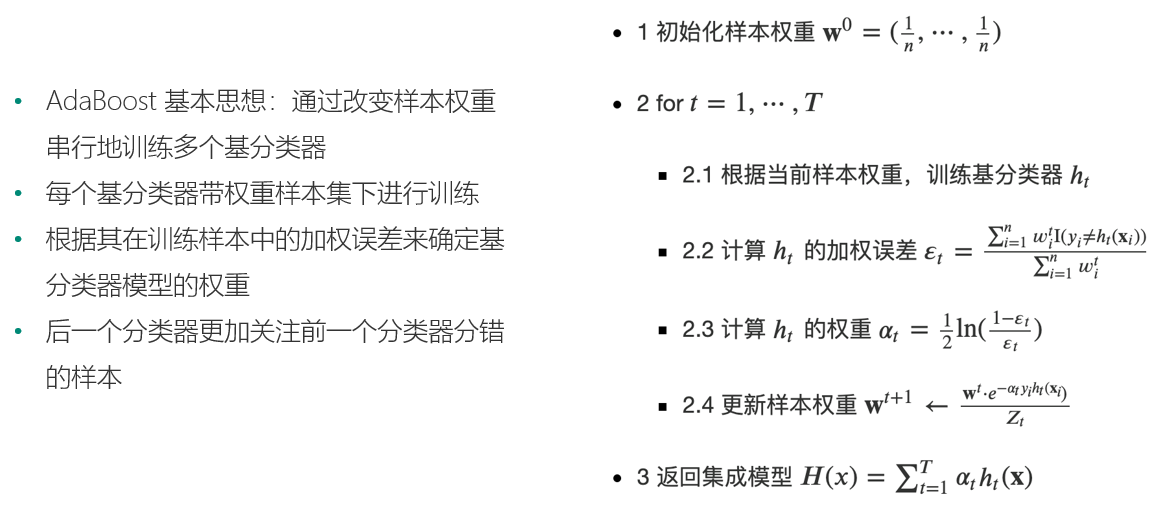

AdaBoost:站在前人的肩膀上前进

误差分析: